トピック

グーグルはなぜ台湾でハード開発するのか 「AndroidでAirDrop互換」も生んだ重要拠点を公開

2026年2月10日 08:20

Googleは多層的なビジネスを展開しているが、今や大手スマートフォンメーカーの一角でもある。特にアメリカと日本では、同社の「Pixel」シリーズの人気が高い。

Googleの生み出すハードウェアについて、研究開発の一端を担うのが「台湾」だ。Googleは20年前から台湾にオフィスを構え、現在もハードウェアについては、アメリカに次ぐ規模の拠点となっている。

Googleは2月初め、同社の台湾拠点を一部プレスに公開した。また、Pixelのカメラ機能の詳細や、Pixelをはじめとしたハードウェア製造・設計に関わるラボについても説明し、「拠点としての台湾」をアピールした。

筆者もその様子を取材できたので、レポートをお届けしたい。

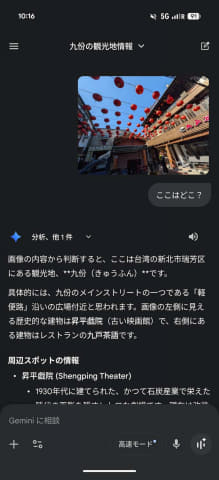

台北・九份をフォトウォーク

最初の取材は、台北有数の観光地である九份でのフォトウォークだ。フォトウォークとは、風光明媚な場所を撮影しながら、その機材のカメラ機能など担当者が解説するものだ。

九份の坂を登りながら写真を撮り、主にPixel 10 Proシリーズの特徴を説明していた。以下、九份の写真はすべてPixel 10 Pro Foldによるものである。

Pixel 10シリーズのカメラが優秀であるのは、いまさら説明するまでもないかもしれない。九份のようにフォトジェニックな場所で、しかも天気に恵まれているため、写真の写りは良好だ。パノラマ写真のように複数の写真を合成する場合、PixelのオンデバイスAIによってショットごとの露出・色合いなどを合わせるわけだが、その調整もかなり上手くいっている。

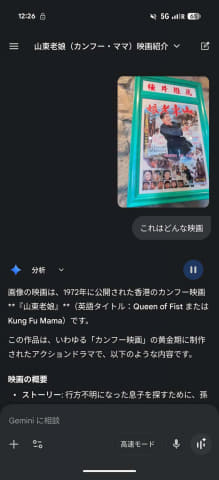

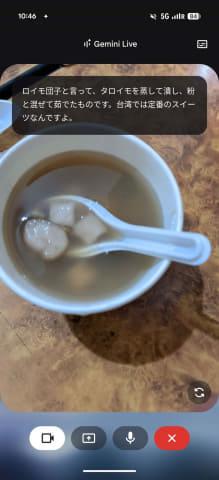

海外旅行などで使う場合、GeminiのようなAI連動が有用なのも、改めて確認できた。Geminiに画像をアップロードして質問してもいいし、カメラで質問したいものを映しながら質問する「Gemini Live」も便利だ。こうした機能がPixelだけでなく、他のAndroidやiPhoneでも、アプリ経由で利用できる。

自社の強みをトータルで見せられるという意味で、九份でアピールするのはいい作戦だったように思う。

全てが近くにある「台湾」の強み

次の取材地は、Googleの台湾オフィスだ。Googleは台湾に複数の拠点を持っているが、中でも規模が大きいのは、ハードウェアの研究開発拠点だ。20年前から台湾に存在するが、Pixelを開発するようになったこの10年間で特に大きくなった。

Googleでハードウェアエンジニアリング担当バイスプレジデントを務めるエルマー・ペン氏は、「台湾に拠点が設けられている理由はクラスターエコノミーにある」と話す。TSMCなどの半導体メーカーに製造企業、サーバー関連企業が自動車で数時間以内の距離に集まっていて、必要な作業とコミュニケーションが素早く進むためだ。

そんなGoogle台湾では、Pixelシリーズをはじめとした同社のハードウェア製品が開発されている。中でもPixelの価格重視モデル「a」シリーズは、台湾チームが中心になって開発を続けているものだという。

台湾・研究開発拠点をチェック

様々な製品の研究開発のため、多数のラボが設けられている。今回はその中のいくつかの中に入り、写真や映像などの撮影が許された。

まずは「オーディオ ラボ」。

Pixelの音声通話性能などを検証するための場所だ。音の反射を抑える無響室が用意され、通話時の音がどのようにデバイスに伝わるかなどがチェックされていた。

その結果の1つが「マイボイス通訳」。通話中に自分の声を使って異なる言語との間のリアルタイム通訳通話をする。その際には周囲のノイズも消え、相手に声だけがちゃんと伝わる。

また、人はスマホを色々なスタイルで持つ。そのため、スマホを保持する場所を指定した場所へと変更するロボットアームが用意されていた。複数の定まったパターンでスマホを保持し、確実なチェックを行なうためのものだ。

次に「デザイン ラボ」。

ここはPixelシリーズのボディデザイン・設計を主に担当する部門だ。今回の取材では、二つ折りである「Pixel 10 Pro Fold」の設計や素材開発について説明された。使われている表面素材やヒンジなどの実物が公開されたほか、熱テストやひっぱり強度試験なども公開されている。

3つ目が「耐久試験ラボ」。ここが最もわかりやすいラボかもしれない。

スマホは日常的に持ち歩くため、落下や擦り傷など、多数の課題に直面する。長く使える製品を目指すには、そうした課題への対策と検証が必須になる。そのためどのメーカーも、製品の落下や破損対策試験を積極的に行なっている。Pixelも例外ではない。

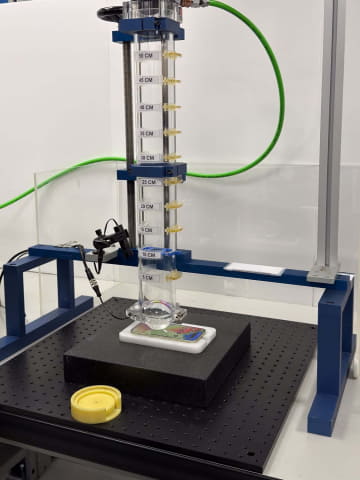

例えば防水性については、定められた規格に沿った検査機械を使い、Pixelに水をかけて浸水状況を確かめている。

Pixel 10 Pro Foldのような折りたたみ型では、開閉をひたすら続けて耐久性を確認する。Pixel 10 Pro Foldの場合、約20万回の開閉に耐えるという。

落下テストも同様だ。様々な高さからPixelを落として破損があるかを確かめることに加え、Pixelのガラスや裏面、カメラ部などさまざまな部分に、高いところからアクリル球などを何度も落として強度チェックする項目もある。

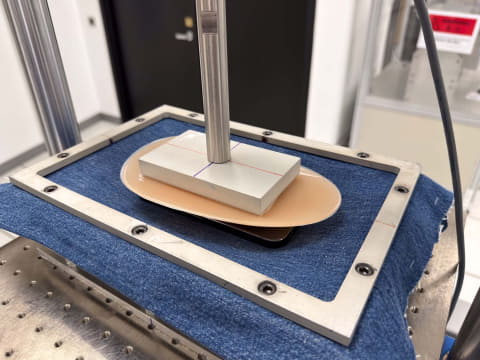

同様に、スマホが服の中で「強く押し付けられる」ことに対する強度もチェックする必要がある。以下の写真は、肌を再現したシリコンと衣服を再現したジーンズ生地の間にPixelを挟み、強い圧力をかける試験のものだ。

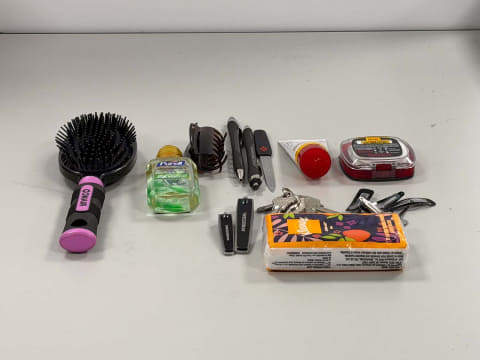

Pixel表面のガラスなどへの影響を調べるため、カギやペン、ティッシュペーパーなどを一緒に入れて回転させるテストもあった。

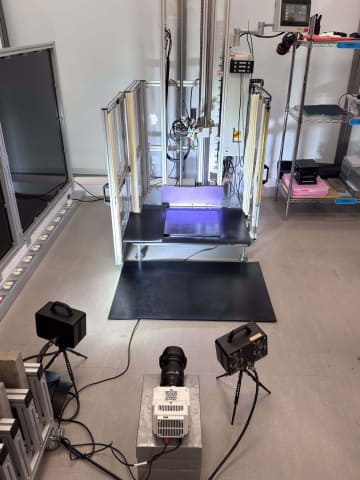

最後は「通信・センサー ラボ」。

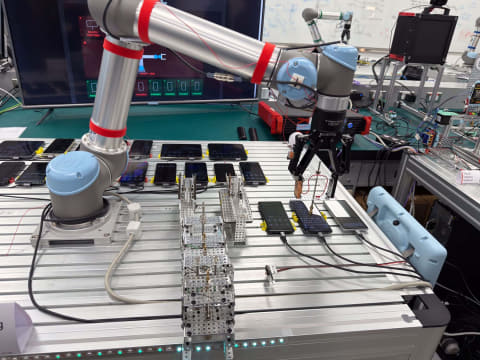

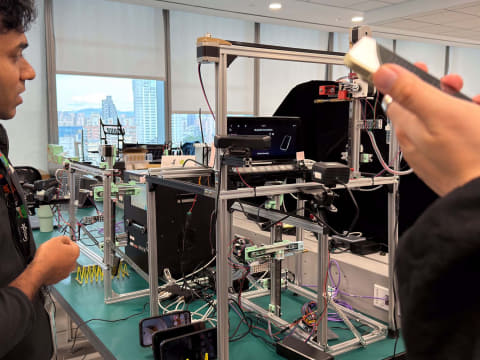

こちらは、Pixelやそのエコシステムで使われるセンサーのテストに関わる部門だ。テスト対象となる機種は多岐に渡るので、ここではロボットをどう使うかがポイントになる。

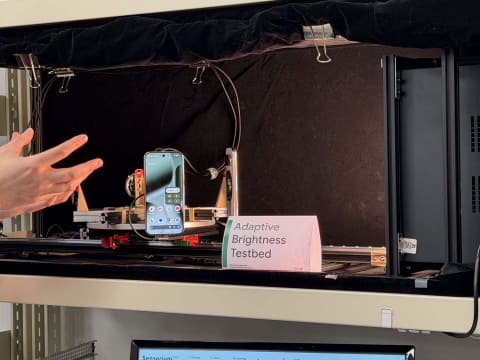

例えば、Pixelの照度センサーのテスト。こちらでは、複数のPixelを立てて回転させ、光源までの距離を変えてチェックする。

特定の操作を繰り返すロボットもある。

これらはそのまま製造に使われるわけではない。だが、ここで開発されたものが工場などに導入され、大量のテストに使われる。そのため、工業用ロボットだけでなく、金属板や3Dプリンターなどを多用したテスト機材が多数作られ、日々、改良されているという。

GoogleのAndroid・Pixel担当者が語るそれぞれのプラットフォーム

今回は、Googleの担当者による、AndroidおよびPixelに関する質疑に答えた。以下、その様子を抜粋してお伝えする。

記者からの質問に答えたのは、Androidプラットフォームのエンジニアリング担当バイスプレジデントのエリック・カイ氏と、Pixelエコシステムのプロダクトマネジメント担当バイスプレジデントのヴェンカット・ラパカ氏だ。

――AndroidとPixelのミッションは?

カイ氏(以下敬称略):Androidが目指すのは、「すべての人のための技術開発」と「オープン性」。スマートフォンだけでなく、時計・テレビ・自動車など多様なデバイスが連携するエコシステムの構築を目指している。

ラパカ:Pixelの狙いは、「Googleのベスト」をユーザーに届けることだ。ハードウェア、ソフトウェア、AIへのフルスタックな投資を行なっており、これは10年前から続く戦略だ。

――2025年を振り返り、どのような点が重要だったと考えているのか?

カイ:AIが重要な要素になった。だがAI自体が目的ではなく、ユーザー体験を向上させるためのツールである。好例は、画像への「かこって検索」だろう。盗難検知や、通話内容を把握しての詐欺対策などもこれにあたる。

ラパカ:ユーザーはAIを意識せず「タスクの完了」を求めている。

――スマホの製品寿命と耐久性の今後については?

カイ:現在は7年間のアップデート保証が可能になってきた。古いデバイスで新機能を動かすのは大変だが、ユーザーや環境のために重要な要素だ。

ラパカ:Pixelについては、特に耐久テストの強化や、修理のしやすさの改善にも取り組んでいる。

――2026年にはどのような点を期待できるのか?

カイ:AIについては、ユーザーが操作するのではなく、デバイス側から提案する、プロアクティブな要素が増えるだろう。例えば、遅刻しそうな時にAndroid Autoが「遅れそうなのでメッセージ送りましょうか?」と提案するような機能だ。

また、OS間の相互運用性を高め、機種変更時のデータ移行の簡素化にも注力する。その1つが、AndroidでのAirDrop対応で、特に気に入っている。

ラパカ:具体的な新製品については言及できないが、今年も、美しくデザインされたハードウェアと、AIの限界を押し広げる製品が登場することになる。

――OS間の相互運用について。特にAirDropでの相互接続は、どのように実現されたのか?

カイ:台湾の本当に優秀なエンジニアたちが、互換性のある独自の実装を構築したものだ。我々が独自に再現し、iPhoneやMacBookが「正しいAirDrop相手だ」と認識できるような仕組みを作り上げた。

Pixelを持つ利点の一つは、ハードウェアを含めた投資を行なっていることだ。この強みを活かし、通常であれば実現できないような検証を独自に進めることができた。

すでにこの技術は実証が終わった段階だ。次は、Pixel以外のAndroidパートナー企業にも広げ、Android全体のエコシステムで使えるように動いている。

非常に近いうちにエキサイティングな発表ができるはずだ。

――AirDrop以外のクロスデバイス対応は?

カイ:セキュリティとプライバシーを確保したインフラ整備を進めている。メディアストリーミングやデバイスセットアップの共有など、多くの機能が開発中だ。

また、iOSからの移行の際、ホーム画面の設定をそのままAndroidにも引き継げるよう、開発を進めている。

――オンデバイスAIとクラウドAIのバランスはどう取るのか?

カイ:これは現在、もっとも難しい研究課題の1つであり、明確な答えは出ていない。

デバイス上のAIは、大量の周辺環境データ、中でも特に機密性の高いデータを扱うのに向いている。通話中の音声は好例で、クラウドに送信したくない。こうした情報の処理は、今後もデバイス上のAIに止まるだろう。

もちろん、高性能な最新AIモデルが必要な場合もある。そこではクラウドが必須だ。

難しいのは、多くの処理がこの中間に位置することだ。

例えば電波状況が悪い時、シームレスに切り替えて、オンデバイスから「そこそこの回答」を得られるようにする、あるいは、コスト削減の観点から、オンデバイスで処理を行なうといったことも考えられる。

そのためには「この質問はどれくらい高度か?」を推測する必要がある。

それが可能になると、利用者がAIを意識する必要のない、ある種のハイブリッドな世界が実現するだろう。

――Pixel独自の機能とAndroid全体のバランスは?

ラパカ:多くの機能がAndroidに提供されることになる。

一方でPixelは、ハードとソフトの融合が重要。カメラ機能などを中心に、機能が「最初に」「最高品質で」提供される場でありつづける。