ニュース

NTT、心に思い浮かべた映像を言語化「マインド・キャプショニング」

2025年11月18日 08:00

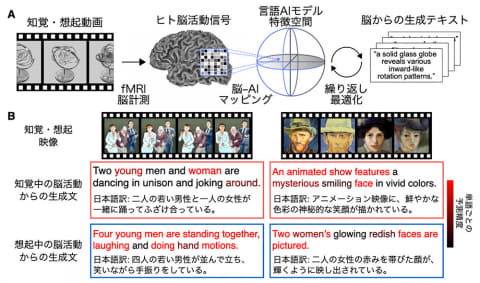

NTTは、脳情報の読解技術と言語AIモデルを組み合わせ、人間が心に思い浮かべる映像を言語に変換して生成できる「マインド・キャプショニング」技術を実現した。

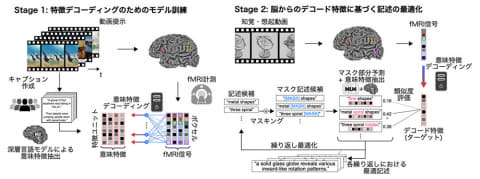

脳活動のパターン解析により心や身体の状態を解読する「脳情報デコーディング」に人工知能(AI)モデルを組み合わせた「脳-AI統合型デコーディング」を、言語AIモデルの導入によって拡張したアプローチ。言語AIモデルの表現力と生成力を活用することで、脳内の意味情報と整合性の高いテキストの生成を可能にしている。

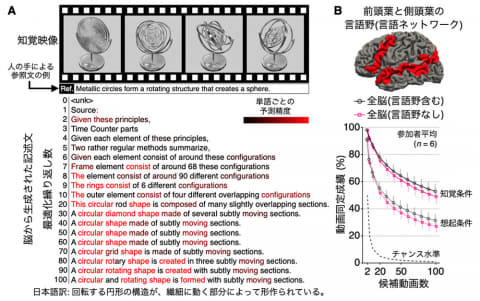

さらに、脳の言語野の活動を使わず、人間が「見た」「想起した」映像に関する非言語的内容を、脳活動から言語へ変換できることを実証。言語的思考を再構成するのではなく、非言語的思考を言語へ翻訳して解釈可能にする新たな脳情報デコーディングの可能性を切り拓く試みという。

具体的には映像を見たり想起したりしている時の脳活動信号をfMRIによって計測。映像の内容は言語AIモデルも理解しており、その内容と脳活動信号の状態を繰り返しすりあわせながら言語化の精度を向上させている。

実験では、実際に映像を見ている最中の脳活動信号と、見た映像を思い出している状態の脳活動信号からテキストを生成した。

たとえば、「若い男性と中年の男性、若い女性の3人が踊っている」動画を被験者が視聴している最中の脳活動信号に本技術を適用すると「二人の若い男性と一人の女性が一緒に踊ってふざけ合っている」とテキストを生成。実際とは完全に一致はしないものの比較的精度が高く出力されている。

映像をリアルタイムで見ている状態ではなく、被験者が映像を思い出している状態の脳活動信号からは「四人の若い男性が並んで立ち、笑いながら手振りをしている」と生成。一致する要素は少なくなるが、それでもある程度は映像の内容を反映したものを生成することが可能だった。映像を想起している状態からのテキスト生成は世界初の成果。

また、言語処理に関する脳部位(前頭葉から側頭葉に渡る言語ネットワーク)の活動を除外しても全脳を使用した場合と同様にテキスト生成が可能であることも確認。これにより脳内の言語情報を再構成しているのではなく、非言語的な情報を言語として解釈が可能になっていることが示されている。

将来的には、視覚以外の感覚イメージや感情、概念的思考など、多様な非言語的思考を言語へ翻訳するための汎用技術として発展させ、発話困難者の意思伝達支援などにも活用する。

研究では、Webから収集した動画を使用しているが、例えば「人が犬を噛む」といった非典型的な場面への汎化性能は検証されていない。今後は今回の技術が脳内の情報をどの程度正確にとらえているか、より詳細な検証を行なう。

ただし、今回の技術は、個人の心的プライバシーに対する懸念も内包している。現在の技術では実験参加者との長時間にわたる取り組みと、大規模なデータ取得が必要で気軽に試せるものではないが、将来技術が発展すれば、より少ないデータから人の思考を解読できる可能性がある。本人の意図に反してまだ言語化されていない思考内容が推定されるリスクもあるなど、想定される課題も多く、技術と倫理の両面を深めながら開発を進める方針。