西田宗千佳のイマトミライ

第327回

グーグル「Genie 3」で「ゲームは作れない」 それでも映像の未来に与える影響

2026年2月9日 08:20

新しい技術が発表されると多くの「驚き」が生まれる。驚きを生み出し、その可能性を考えることは重要なことだ。

一方で、驚きが広がった結果が、技術を開発している人々の思惑や現状で可能になることとはずれていくことも少なくない。多くの企業の株価が動き、経済的な影響も出てくる。

特に最近発表されたもので、そのズレが大きいと感じているのが、AIで歩行・移動可能な世界を生成する「Genie 3」だ。

Google DeepMindからGenie 3が発表され、アメリカで一部のユーザーが利用可能になると、ソーシャルメディア上には「有名なゲームがすぐに再現できる」「もうゲームは誰でも作れる時代」という話題があふれた。

だが、これは正しい理解ではない。

Genie 3は素晴らしく、可能性に満ちた技術ではあるが、それだけで「有名なゲームと同じものが作れる」ことはないし、現状でゲーム開発にそのまま使えるものでもない。

では、そこにはどんな誤解があるのだろうか。

そして、Genie 3の先にある本当の可能性とはなんなのだろうか?

今回はその話をしてみよう。

ワールドモデルで映像を生み出す「Genie 3」の衝撃

まず、Genie 3の解説をしてみよう。

Genie 3はいわゆる動画生成AI技術だが、特徴は「キーなどの入力に合わせ、世界の中を移動できる」という点だ。

一般的な動画は、当然ながら画角などが固定だ。カメラで撮影したものであろうと、動画生成であろうと変わらない。

だがGenie 3は、キーボードの入力に合わせ、生成された世界の中を移動できる。右に曲がると指示すれば、見えている視界の右方向が描かれる。指示に合わせて進む方向がリアルタイムに描画されるわけだ。

どんな世界の中を動くかは、プロンプトから記述して決められる。また、移動する「自分」がどんな姿なのかも決められる。要はNano Banana Proを使って生成した画像をベースに、そこから世界を構築していくわけだ。

また、すでに出来上がった世界であっても、プロンプトの入力によってカスタマイズしていくことができる。

こうしたことを実現するには、生成AIのモデルの中に「ワールドモデル」と呼ばれる概念が必要になってくる。

ワールドモデルとは、世界がどのような構造かを理解する能力を持ったAIのこと。世界のビジュアルを構築するだけでなく、指定した速度や重力などを再現し、操作に合わせてリアルタイムに動画を生成していくには、「向いている方向に移動した時にどうなるか」を理解している必要が出てくる。また、移動した結果元の場所に戻ってきたなら、元の場所がそのまま描画される「一貫性の維持」も必須だ。

世界を理解する、という要素はAGI(Artificial General Intelligence、汎用人工知能)を実現する上では重要な要素となる。Genie 3はその流れのなかにある。まだまだ要素技術は不足しており、Genie 3ができたからといってAGIが作れる、と単純に結論づけることは難しい。

しかし、重要かつ大きな一歩であることは間違いない。それが研究室の中だけでなく、一般にも(アメリカ限定、しかも高額なサブスクリプションの加入者向けとはいえ)公開されたことは、大きな価値を持っている。

Genie 3とゲームの違いは「インタラクティビティ」の重さ

操作に応じてリアルタイムに、しかもプロンプトで指示した「自分が思う世界」を描く、というGenie 3の登場は、大きなインパクトを持っている。

結果としてソーシャルメディア上で起きたのは、Genie 3で「ゲームの映像を再現した動画をシェアすること」だった。

あえてここで紹介することは避けるが、著名なゲームに似た映像をGenie 3で生成し、「何年もかかって開発されたゲームが目の前ですぐ再現できた」と騒がれていた。

ゲーム開発にはコストと時間がかかる。それを生成AIで軽減できないか……という話は多数あり、どのゲーム会社も研究・実践を進めているところだ。

それがいきなり、Genie 3のようなAIモデルですべて解決され、それどころか、個人の手によって簡単に実現できてしまう……。ソーシャルメディアでの騒動は、そんな解釈を広げてしまうものでもあったと言える。

では、この認識は正しいのか?

はっきり言えば、大きな間違いだ。Genie 3がそのままゲーム開発につながるものかというと、多数の点で違いがある。違いと課題を挙げていくときりがないほどだ。

簡単なところからいこう。

まず、ゲームは「映像が表示される」だけではできない。移動一つとっても、ゲームはそれぞれ「そのゲームが必要とする要素」を組み合わせて決定されている。

ゲームによってキャラクターの動きが違うのは、開発上の事情なども存在するが、なによりもゲームを作る側が「どのような動きがベストなのか」を考えた末に決めたものである。

動く・ジャンプする・動いた先で敵を殴る、といった無数の動きは、すべて「ゲームとしての選択」の結果だ。同じような動きに見えても、ゲームそれぞれでスピードや挙動が異なっているのは、最適かつインタラクティブ(双方向性)な体験を作っていくために、ゲーム開発者が工夫を凝らしているからである。

さらには、動きにあわせた「音」もきわめて重要。操作や動作に合わせた音があり、その相乗効果で体験が拡大していくのがゲームの本質だ。

ゲームとは映像だけで構成されるのではなく、インタラクティビティが軸にある。インタラクティビティの構成要素として映像があるのだ。

Genie 3で再現された映像はあくまで映像であって、ゲームを構成するインタラクティビティは欠けている。さらに言えば「オリジナリティのあるインタラクティビティ」は作れていない。

Genie 3はゲームエンジンとしては作られておらず、インタラクティビティを作り込むことはそこまで重視されていない。Genie 3の外側から多数の要素をAPIで制御すれば可能になるかもしれないが、それはまた別の話でもある。

次に、世界構成の問題。

ゲームは「行き先でどのようなことが起きるか」を積み上げて作られている。それは「建物がある」「敵がいる」ということだけではない。どこまで進むとどんなことが起きるのか、という情報は必須だ。その構築によってゲーム内容は決まるし、操作した結果も決まる。

Genie 3でもそうした要素を勘案することは不可能ではないかもしれない。APIを介して逐次介入すれば実現できなくはなさそうだ。

だが、これもまたインタラクティビティ同様、簡単に作れるものではないし、少なくとも、単独でGenie 3を使っただけでは再現できない。

最後に、最も大きな「コスト」の問題。

Genie 3は逐次映像を生成しているので、利用するプレイヤーごとに生成演算コストがかかる。例えば、1,000人のプレイヤーがGenie 3をベースとしたゲームをプレイしたとすれば、1,000人分×プレイ時間分、Genie 3を動かすサーバー負荷が発生する。これでは、ゲームをプレイする人に対して提供できるコスト感を実現するのはほぼ不可能だ。

それに対し、ゲームのほとんどはローカルの機器で動く。演算コストは機器の電気代くらいのもので、何時間・何人がプレイしようと、サーバーコストはたかが知れている。

さらに言えば、ゲーム開発中には多数の試行錯誤が必要になる。インタラクティビティから生まれる体験は、多数の試行錯誤の結果、「これが気持ちいいだろう」とゲーム開発者が選択した結果でもある。その試行錯誤にも全てGenie 3の演算コストがかかるとすれば、開発費はどのくらいになるのだろうか?

現状、Genie 3は最大60秒の映像しか生成できない。これはGenie 3が映像を作る商用サービスではなく実験的なプロトタイプであるためだが、大量の人々が長時間プレイする=演算コストの面で現実的ではない、という話ともつながっている。

これらのことから、Genie 3でゲームを作るのはかなり難しく、「ゲームの映像を再現」することはできても、オリジナルのゲームを作るのは厳しい、ということがわかる。

だから「Genie 3でゲーム開発が変わる」「Genie 3でゲームエンジンが死んだ」というのは、現状では正しくない見方だと断言できる。

ただし、Genie 3でできないことがGenie「4」ではできるかもしれない。インタラクティビティの一部が再現できるかもしれないし、演算コストも下がるかもしれない。

とはいえ、ゲームに求められる要素をAIモデルだけで実現するのは難しい。人間以上に柔軟で幅広い判断を、同時にこなすAIが必須になる。それができたとき、そのAIモデルは「AGI」だと定義していいくらいだ。

だから現実的には、ゲームを構成するために必須の部分をすべてAIで実装するより、別のソフトウェアがAIを呼び出して映像生成の一部を担わせる……というのが現実的な路線だろう。

「AIで世界生成」を目指す企業は多い

生成AIとゲームの関係という意味では、次から紹介する2つの事例を頭に入れておく必要がある。

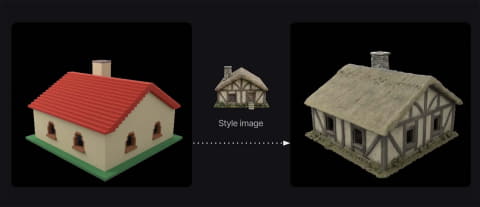

1つ目は、昨年9月、Metaが公開した、同社のメタバース「Horizon Worlds」に、生成AIによってワールドを生成する技術だ。以下の記事後半で筆者も触れている。「Metaはメタバース事業出資を縮小したのでは」という人もいるだろうが、ちょっとその話は傍に置いてほしい。ここから紹介する技術は、むしろメタバースのコストを下げることにもつながるものである。

この技術は、プロンプトでユーザーが歩き回る世界を全て生成する。例えば「西部劇風の田舎で、アイテムとしては古い食料が出てくる」「ゾンビが闊歩するポスト・アポカリプスの世界で、アイテムは古びたレーションの缶」といったことが、プロンプトだけで作られる。風景の詳細や銃を撃った時の音、ヒット音に地面を掘る音などの効果音も、プロンプトが指定した内容に相応しいものが出来上がる。

前掲の動画はシンプルなものだが、筆者は取材中に「撮影NG」という条件で、実際の動作をかなり詳しく見ることができた。そこでは、まっさらな世界に次々プロンプトを入れていくことで、オリジナルの「ゲームとしても遊べる世界」を構築していた。

2つ目の技術は、同じくメタバース的なワールド・サービスである「Roblox」の新技術。こちらは先週発表されたばかりである。

Robloxもワールドやオブジェクトをプレイヤーが作り、その中で多くの人がコミュニケーションすることが魅力である。

ただ、形状を1から生成するのは大変だし、遊んで楽しい挙動を作りこむのも大変だ。

そこでRobloxは、ワールド内で使うモデルをプロンプトから生成可能にした。操作した時の動きなどの挙動も同時に生成される。

将来的には自然言語で環境全体を生成することを目指しているという。これはまさに、Metaが目指しているものと同じである。

この2社の事例は「AIで自分たちが歩き回る世界を簡単に生成する」という意味では、Genie 3が目指すものとも同じに見える。

実際、こうしたメタバースの課題は「世界生成がとても大変である」ことにある。

2023年4月、MetaのCTO(最高技術責任者)であるアンドリュー・ボスワース氏にインタビューしたとき、彼は「メタバースにはホロデッキが必要」と話した。その様子は以下の記事に詳しい。

ホロデッキとは、SF作品「スタートレック」シリーズに出てくる技術。音声でコンピュータに指示すると、指示した内容に合わせた現実と見紛う世界が自動的に呼び出される。

ホロデッキのように世界を生成してくれるなら、人々は気軽に自分たちだけの世界で色々な体験を楽しめる。結局のところ、GoogleにしろMetaにしろRobloxにしろ、ホロデッキと同じようなビジョンを実現したいと考えており、AIが必須だと考えているのだ。

ただし、MetaやRobloxはより現実的かつすぐに自社ビジネスに使える技術を志向している。だから、オブジェクトやインタラクティビティに必要な要素を生成し、画像自体はいままで通り、リアルタイムCGで再現している。最終的な狙いは似ていても、そのアプローチはより現実的で異なるものだ。

産業で進むゲームエンジン活用 その先に「ワールドモデルAIの必要性」も

Genie 3とその先の技術は、ゲームやメタバース的なサービスに影響するだけではない。

理由は、ゲームエンジンがゲームだけでなく産業でも使われるようになっているからだ。

最もわかりやすいのは、映画やドラマの撮影の背景として使われる「LEDウォール」向けの映像生成だろう。以下の写真はソニーグループが2025年のCESでデモしていたものだが、背景は完全にCGであり、ゲームエンジンであるUnreal Engineで制御されている。

また1月末から2月頭までベルギーで開催されたオープンソースイベント「FOSDEM 2026」では、トヨタ自動車のグループ会社であるToyota Connected North America (TCNA)が、オリジナルのゲームエンジンである「Fluorite」を発表した。パフォーマンスが高く、GoogleのレンダリングエンジンであるFilament rendererを採用。最新の家庭用ゲーム機グレードの映像を生成するとされている。

トヨタのような企業がゲームエンジンを求めるのは、自動車開発における挙動や外観のチェックから広告マテリアルの作成まで、多数の要素でリアルタイムCGを必要とするからだ。

最近「フィジカルAI」という言葉を聞くことも増えた。この技術は、現実世界でロボットや自動車を安全に動かすために、コンピュータ内でのシミュレーションを拡大していくことを指す。その場合には、ゲームエンジンを使って再現されたデジタルツインの中で色々なものを、物理空間での挙動を認識して動かしていくことが必須であり、効率的な運用と解析、データ増加にAIでの生成が欠かせない。

映像制作でもロボットや自動車の開発にもゲームエンジンが必要だが、そこで必要になっているのは「リアルタイムCGを簡単に扱う」能力である。ゲームほど徹底したインタラクティビティは必要ないが、インタラクティビティがあるからこそ開発効率が上がる。

現状、コストと品質を考えると、この分野でもGenie 3をそのまま使うことは難しい。オブジェクト生成の補助などにAIが使われている段階だ。だが、フィジカルAIとして生成AIを活用する領域が増えていく中では、ゲームエンジンとAI生成の融合が必須になる部分が出てくるだろう。

Genieの先で見据えているのは、そうした活用の方だと感じる。

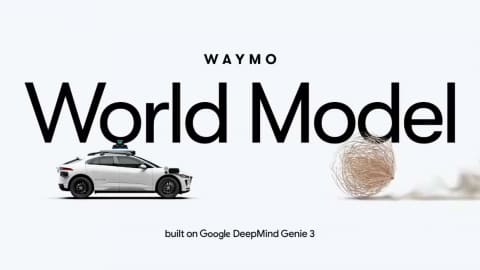

2月6日、Google系列の自動運転関連企業であるWaymoは、Genie 3を応用した自動運転シミュレーションモデル「Waymo World Model」を発表した。これはまさにフィジカルAIとしてGenie 3の機能の一部を活かしたものであり、ワールドモデルの活用例そのものだ。

We’re excited to introduce the Waymo World Model—a frontier generative mode for large-scale, hyper-realistic autonomous driving simulation built on@GoogleDeepMind’s Genie 3.

— Waymo (@Waymo)February 6, 2026

By simulating the “impossible”, we proactively prepare the Waymo Driver for some of the most rare and…pic.twitter.com/Pl80OMDqLC

現状、CG制作にはコストがかかる。それは、映像を作るための素材作りに手間がかかるからであり、手間の軽減には人手をかけることが近道だからでもある。

だが、CGの作り方を変えていく過程でAIの関与度を高めていくことができれば、もっとコストと作成スピードを変えていけるかもしれない。

その先では、今までの「オブジェクトの位置や性質と光源、カメラの位置から映像を再現する」という、3D CGのあり方が問われる時代が来るかもしれない。同じようなものをいきなりAIで生成できるなら、「3D CGのレンダリング」という過程を経る必要がないからだ。

だが、今はまだその時ではない。すぐ先の未来でもない。とはいえ、いつかは影響してくる。

Genie 3はゲームを再現できていない。だが、それは開発途上であるからだし、そもそもゲームエンジンとして作っているわけではないからだ。

しかしCGとそれを支えるツールの世界にとって、「ワールドモデルを使ったAI」の存在は、将来的に大きな影響を与える可能性はある。その可能性は、ゲームエンジンメーカーの行方を左右する。

Genie 3が公開されると、Unity Technologiesなどのゲームエンジン関連事業の株価が下がった。その理由の大半は、「Genie 3でゲームが作れる」という誤解によるものだろう。だがより先を見据えると、ゲームエンジン企業の株価と、ワールドモデルAIの間が「無関係」というわけではない。