西田宗千佳のイマトミライ

第324回

アップルはなぜGeminiを採用するのか その深層にある「スマホAI競争」

2026年1月19日 08:20

アップルとGoogleは1月12日(アメリカ時間)、次世代のApple Foundation Modelとして、Googleの「Gemini」を採用すると発表した。

契約は複数年に渡るものされ、2026年中に登場する「パーソナライズされたSiri」を含め、Apple Intelligenceで将来実現される機能の多くでGeminiが採用されることになる。

この発表はどういう意味を持っているのだろうか?

アップルはAIで遅れている、と言われ続けてきた。その結果としてGoogleとの提携を選んだことになる、という点は事実として間違いではない。

だがそれは「iPhoneとAndroidのAI機能が同じになること」を指すものではない。そして、スマホとAIの関係の未成熟さを示すものでもあるだろう。

実は、今回出されたステートメントは非常に短いもので、そこから正確な方向性を把握するにはかなりの背景知識を必要とする。

この発表でもたらされるものの意味と価値について、解説してみたい。

Geminiになってなにが変わるのか

今回の発表では「次世代のApple Foundation ModelにGeminiを使用」と説明されている。

Apple Foundation Modelとは、iOSをはじめとしたアップル製品のAI技術である「Apple Intelligence」で使われるAIモデルのことだ。

現状、ここがGeminiベースになることで機能がどう変わるかは、アナウンスされている情報は少ない。

明言されているのは「Siriの改善」だが、これは「2024年6月、Apple Intelligenceのアナウンスされた時に公開されていた機能が実現される」と考えるべきだろう。アプリの使用履歴やメッセージングからどんなことをすべきかを教えてくれたり、アプリをまたいだ複雑な操作代行が実現する、ということは考えられる。

また今もiOSには、「Visual Intelligence」という機能がある。画像を解析して内容を教えてくれたり、スケジュールを登録してくれたりするのだが、この精度がより高いものになることは期待していいだろう。

現状のApple Foundation Modelは、アップルが独自に準備したAIモデルで動作している。だがその品質は、他のAIプラットフォーマーが提供しているものに比べ劣っている。「アップルがAIで遅れている」と言われるのはこの部分だ。

ただ、その本質的な意味を理解するには、Apple Intelligenceを含めた「OSで使われるAIの建て付け」を知っておく必要がある。

理由は、今回の話で注目すべきなのは「デバイス内で動作するAI」の部分であり、特に「スマホの中のAI機能を便利にする効果」に直結している部分だからでもある。

iOSとAndroidの「AI」の違いとは

スマートフォンにしろPCにしろ、現在のOSには多数の「AI機能」がある。それらは1つのAIで成り立っているのではなく、「複数の異なるAIを使った機能」の集合体だ。ただ、使う上で、「どのAIが使われるか」を知る必要は少なく、一般に明示もされない。

Apple Intelligenceは、基本的にはデバイスの中で動作するAIを指す。

アップルは、AIが「個人の意図や行動を理解したサポート」を行なう世界を目指している。そのためには、iPhoneやMacなどのデバイス内にある個人の活動やアプリ使用履歴、メッセージなど、機密性もプライバシーも求められる情報を扱う必要も出てくる。それらをクラウドに転送・集積して扱うのは好ましくない……との観点から、処理は「基本的に」デバイス内で完結する思想だ。

Apple IntelligenceからChatGPTを呼び出す機能もあるが、これはあくまで「Apple Intelligenceと外部機能の連携」の一例であって、Apple Intelligenceそのものではない。今回の件で「OpenAIからGoogle」という説明も見かけたが、これは正しくない。

現状、こうした外部連携がどう変化するかはアナウンスされていない。Apple Intelligence発表時には「外部連携はOpenAI以外にも選べるようにしたい」とのコメントもあり、併存する可能性もある。

Androidの場合には、Apple Intelligenceにあたる「OSで使われるAIモデルのブランド」が「Gemini」になっている。

Apple Intelligenceと異なり、Geminiについては機能によってデバイス上で動くAIか、そうでないかが混在している。Google全体で提供しているAIサービスのブランドもGeminiであり、それらで使われるAIモデルの名称もGemini。Googleはとにかく、名称のシンプル化に努めている。

さらにその上に、各スマホメーカーが独自に採用したAI機能があり、それぞれのブランドがついている。

一般的な理解としては「Apple Intelligence対Gemini」のような印象であり、間違った話でもないのだけれど、実際に示すものや使える機能の建て付けはかなり異なっている。

「カスタマイズしたGemini」を利用か

今回アップルとGoogleのステートメントの中ではApple Foundation Modelにフォーカスして語られている。

これは前出のように、「Apple Intelligenceの中で使うAIモデルが変わる」という話であり、Apple IntelligenceがAIサービスとしてのGeminiに置き換わるという話ではない、ということだ。

Apple Foundation Modelと同様の仕組みはAndroidにもある。こちらは「Android AICore」と呼ばれており、その中身は、Geminiの中でもコンパクトなAIモデルであり「Gemini Nano」だ。

ということは、Apple Foundation ModelがGemini Nanoに入れ替わる話なのか……という展開になるのだが、実際にはこれでも正しい理解ではない。

ステートメントでは「次世代のApple Foundation ModelはGoogleのGeminiモデルとクラウドテクノロジーを基盤とする」と書かれており、Geminiそのものとはなっていない。

理由の1つは、Geminiをベースにアップルが独自のカスタマイズを加えるからだろう。

AndroidとiOSでは、AIに対する考え方が異なる。Apple Foundation ModelとAndroid AICoreも、似ているがイコールな存在ではない。

Apple Foundation Modelは、アップルのOSに紐づいて実装されている。OSもアプリもAIモデルを直接操作するのではなく、「OSが持っている機能をアプリなどが呼び出す」構造だ。だから機能の一貫性を保ちやすく、開発もより容易なのだが、自由度は低くなる。OSと密結合している部分、AIモデルの品質が機能に大きく影響しやすい。

Android AICoreはGemini Nanoをそのまま提供していて、アプリからその機能が自由に使える。だが、あくまで「AIモデルが載っている」状態であり、アプリでどう使うのか、どう呼び出すと効率的であるのか、という点はアプリ開発者の努力に依存する。AndroidというOS上にあるAI機能はそれらを使って各々実装されている形だ。

さらに、AndroidではOSに関わる機能もクラウドとデバイス内処理を併用している。そうすると、「OSをAIで便利にする」場合に求められる機能はイコールではなくなる。

もう1つの事情として、アップルが使うAIモデルがデバイス内処理であるのは「基本的には」という留保がある、という点がある。

デバイス内で動作が完結するAIモデルは、どうしてもサイズが小さいものになる。AIのモデルサイズは賢さに直結するため、OpenAIの「GPT-5.2」やGoogleの「Gemini 3 Pro」ほど賢く規模の大きな処理を行なうのは難しい。

それでも機能の内容によっては、より大きなAI処理を必要とする場合がある。

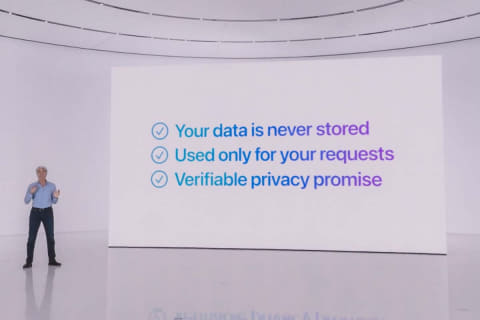

そこでアップルは、「Private Cloud Compute」という独自のクラウドを用意し、「処理の足りないAI処理」をこちらに回すようにしている。

その上でプライバシーを確保するため、

- 処理はすべて匿名化され、1つ1つ独立

- データを蓄積する機構を持たず、処理が終わると情報は破棄

- ハッキングリスク最小化のため、アップルデバイスからのAI処理にしか使えない

という特徴を持つ。こちらではデバイス内のAIよりも大きな規模のモデルが使えるので、処理の問題は解決しやすい。

Private Cloud Computeでも今後はGeminiベースの技術が採用されるとのことなので、複数のサイズのAIモデルを、アップルのニーズに合わせてカスタマイズした上で採用する……と理解するのが良さそうだ。

なお、「プライバシーに関わり、高速応答性が必要なAI処理はデバイス内でやりたいが、性能問題がある」という課題は、同じくGoogleも抱えているようだ。

そのため同社は、25年11月に「Private AI Compute」という仕組みを発表した。技術の詳細は異なるが、目指すところはPrivate Cloud Computeとほぼ同じだ。

なお、Private Cloud Computeはアップルが自社プロセッサーを使った独自サーバーで動かしており、Private Cloud ComputeはGoogleの独自AIアクセラレータであるTPUを使ったサーバー上で動く。

改善はiOS 27より前か 核となるのは「AIモデル+機能」のセット

この結果としてどれだけの改善がなされるかは、まだ不透明だ。

少なくとも、アップルが当初Apple Intelligenceで想定していた機能は自社AIモデルだけでは実現できず、Geminiベースの新技術ではそれが可能になる……ということは間違いない。

今実現しているものと当初の発表の違いは、2024年6月のWWDCのレポートを読むとわかりやすい。

Googleとの提携交渉はかなり前から進んでおり、背後で相当な準備も進められていると見られている。AIモデル自体は世の中に複数あり、アップルはそのうちのいくつかを評価試験した上で、Googleをパートナーに選んだようだ。

アップルは25年3月、進化版Siriの提供を延期すると発表し、6月の開発者会議である「WWDC」でも、その事実を改めて公開した。

提供時期は当時「今後1年以内」とされており、次期OSである「iOS 27」を待たずに先行投入されるとの見通しもあった。

iOS 27の発表が例年通り6月とすると、その前のバージョンは3月から4月には公開される可能性がある。だとすると、ベータテストは2月のどこかで始まる可能性が高く、今回の発表はその前としてはギリギリなもの、と見ることができる。

一方で、Siriの改善もいきなり全機能が公開されるとは限らず、iOS 27も含め順次公開される可能性は高い。

そもそもAIモデルを入れ替えて、それだけでいきなりスマホ上のAIが便利になるのか、というと、そんなにシンプルな話ではなかろう。それだけでいいなら、AndroidのAI機能はもっともっと高く評価されているはずだ。

翻訳や文字起こし、画像加工などでアップルに先行している部分は多いが、劇的に体験が違うか、というとそこまでではない。

おそらく、AIをスマホ上でちゃんと便利に使うには、まだまだ機能・用途開発が必須なのだ。アップルが2024年6月に提示したビジョンには見るべき部分が多かったが、それがどこまで便利なものになるのか、ピンときた人は少数派だったろう。

OSへのAI実装競争はまだ始まったばかりであり、核となる機能の進化も進んでいない。「賢いAIモデル」は重要だが、それだけでなにかが実現できるわけではない。

アップルにとって賢いAIモデルは必要だが、その上で「どんな状態を作り上げるのか」がさらに重要だ。その部分でアップルが遅れているわけでもなく、まだたいした差は生まれていない……という見方もできる。

アップルは検索エンジンを持っておらず、他社から借りている。だが、そのことはiPhoneを売る上で不利な条件にはなっておらず、むしろGoogleから「検索エンジン搭載料」を得る立場だ。この年間支払額は200億ドル(2022年当時、約3兆円)と言われている。それに対し、今回のGeminiに関する契約は、噂によれば年間10億ドルとされる。

クラウドで動くならスマホはなんでもいい?! 強くなるGoogleの存在感

さらに言えば、「デバイス内処理」にこだわらなければ、巨大なクラウドで動く最新AIモデルも使える。

Googleは1月14日、Geminiのパーソナライズ機能を強化し、よりアシスタント性を持たせる「Personal Intelligence」を発表した。

これはクラウド処理によるものだ。同じように、OpenAIも利用履歴を記録してのアシスタント化を強化している。ManusやGensparkなどのAIエージェント系サービスもクラウドで動く。

画像生成についても、高度なものは基本クラウドで動いている。Googleの「Nano Banana Pro(Gemini 3 Pro Image)」も、Nanoと名がついているがGemini Nanoとは関係なく、すべてクラウドで動作する。

これらがスマホアプリ上で動き、日常的に使われるということにならば、極論スマホはどれでもいい。

そう考えると、AI自体がスマホの差別化要因になるのではなく、むしろ差異を失わせるものになる可能性も高いわけだ。その時には結局、「AIを別にしても使いやすい・欲しいスマホはどれか」ということが重要になってくる。

これはアップルにとってある種の危機であると同時に、勝ち筋になる可能性もある。MacやApple Watchなどとの連携が重視される可能性も高いからだ。

さらに言えば、本当に「個人の処理をクラウド上のAIに依存する流れ」が続くとも決まっていない。クラウドのAIを十分に活用するには、結局サービスに課金する必要が出てくるからだ。

現状でAIに課金している人は少数派だ。Googleが「AIモード」とネット検索を連動し、これまでの広告ビジネスを継続しているのも、OpenAIが広告モデルの導入を決めたのも、結局は「高コストなAIをどう運営していくか」という課題の現れでもある。

デバイス内で完結するAIには、即応性・プライバシー保護に加え「コスト」という利点がある。スマホを買えば(それなりに)高度なAIが使えるなら、サービス加入の阻害要因になる可能性はある。

どちらのシナリオが勝つかはなんとも言えないが、現状は「利便性ではクラウドモデルが有利」という印象はある。AIモデルと半導体の進化、両方が起きる以上、状況が急速に変化する可能性もある。

そう考えるとやはり個人との接点であるデバイスを持っていることは大きな利点であり、AIを借りたとしても、アップルの持つメリットは巨大だ。

一方、Googleはその両方を持ち、1社でほぼすべてのスマホAIを供給する巨大な存在になる。これは非常に大きなことだ。

アメリカでの独禁法訴訟にて、Googleへの風向きは変化した。その辺のリスクも、今回の決定には効いているのではないだろうか。