ニュース

楽天、7000億パラメータの日本語LLM「Rakuten AI 3.0」

2025年12月18日 13:21

楽天グループは、Mixture of Experts(MoE)アーキテクチャを採用した日本語特化の大規模言語モデル(LLM)「Rakuten AI 3.0」を発表した。約7,000億個のパラメータを持つ同社最大規模のモデルで、日本語特有のニュアンスや文化、慣習への理解を強みとする。

性能と効率性のバランスも特徴とし、「楽天エコシステム」のサービスを支える試験では、他社の同規模モデルと比較して最大90%のコスト削減を実現したという。

同モデルは、開発者向けプラットフォーム「Rakuten AIゲートウェイ」の生成AI API群に追加され、Rakuten AIエージェントプラットフォームを通じて各種サービスに順次導入されるほか、2026年春を目途にオープンウェイトモデルとしての公開も予定している。

Rakuten AI 3.0では、計算効率を高めるため、約7,000億個のパラメータのうちトークンごとに約400億個のみをアクティブ化する構成を採用。アクティブパラメータには3つの密な層とエキスパートコンポーネントを含み、各トークンは常にアクティブな「共有エキスパート」と8つの「専門エキスパート」を経由することで、効率的な処理を可能とする。

学習は楽天が設計した社内マルチノードGPUクラスタ上で実施し、隔離された安全なクラウド環境で運用することで、データが外部に送信されない設計としている。また、日本の市場と楽天のビジネスニーズに最適化された独自データでファインチューニングを施し、処理精度の向上を図った。

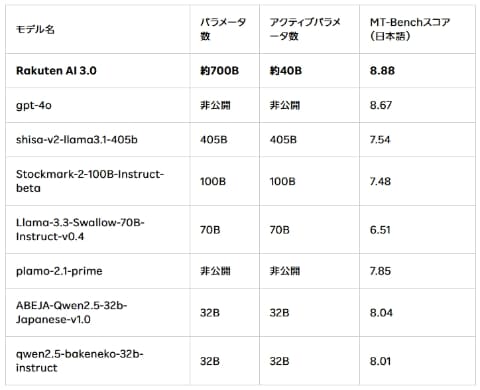

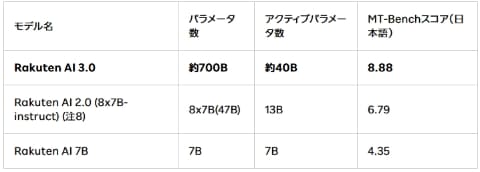

日本語性能については、会話能力や指示追従能力のファインチューニングを行ない、日本語版MT-Benchを用いた評価では、主な日本語LLMや前モデル「Rakuten AI 2.0」のインストラクションチューニング済モデルと比べて高いスコアを示したとしている。

なお、同モデルは経済産業省および新エネルギー・産業技術総合開発機構(NEDO)が推進する、生成AIの開発力強化を目的とした「GENIAC(Generative AI Accelerator Challenge)プロジェクト」の一環として開発された。