西田宗千佳のイマトミライ

第225回

インテルが本腰、「オンデバイスAIの時代 」はどうなるのか

2023年12月25日 08:15

2023年も残りわずかだが、今年のIT業界が「生成AI」に揺れた1年であったのは疑いない。

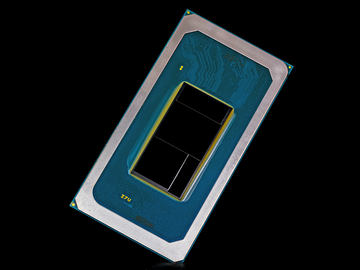

今年最後の大型新製品も、やはり生成AIがらみだった。12月15日、インテルは新世代のPC用プロセッサ「Core Ultra」シリーズを正式発表、日本でもお披露目を行なった。

Core UltraはCPU・GPUを強化したプロセッサであるだけでなく、AI処理に向いたコアである「NPU」を搭載しているのが特徴だ。

インテルは、生成AIを含めたAI処理の「ローカル化」を指向しており、PC用プロセッサもAIに向いた構造にしていく。

「AIのローカル化」はなぜ必要なのか? そしてどう広がり、現在はどんな状況にあるのだろうか。その点を解説していく。

「Core Ultra」でAIをブースト

インテルは現在「AI Everywhere」というキャッチフレーズを使っている。Core Ultraももちろん、この流れの中でプロモーションが行なわれる。

AIは文字通り、あらゆる場所で使われるようになっている。顔認識や音声認識はもちろんだが、ショッピングや映像配信の「レコメンデーション」だってAIによって実現されている。翻訳も精度が上がり、多くの人が使うようになった。

そこにこの2年ほどで、さらに「生成AI」が使われるようになってきた。

AIのニーズが増えるなら、クラウド側で動くサーバー向けのプロセッサでも、ローカルデバイスであるPCでも、AIをより効率的に処理するニーズが高まっていくことになる。

単に高速に、という形ではなく、AIに関する処理をより速く・より低い電力で処理することが求められる……ということだ。

だから、サーバー向けの「第5世代Xeon SP」でもクライアントPC向けの「Core Ultra」でも、AI向けの機能が強化され、あらゆる場所でAIが使える世界を加速する……。それがインテルの考え方だ。

インテルはCore Ultra以降に搭載されるNPUに「Intel AI Boost」という愛称をつけている。これ以上ないくらい、狙いがわかりやすい名前だ。

差別化点は「ローカルでのAI処理」

中でもインテルが強くアピールしているのは、Core Ultraを使った「ローカルでのAI処理」だ。つまり、手元のPC(ローカル)でAI処理の多くを完結するということだ。

現状、AIの多くはクラウドで処理されているが、ニーズが増えるほど素早い動作が求められる。

すべてのデータをクラウドで処理することになると、課題も色々ある。

1つ目の課題は「データ転送自体」だ。転送には時間もコストがかかるが、同時に「クラウドに蓄積することを、利用者もメーカーも望まない」もある。特にPCやスマートフォンから個人的な情報や顔認識、音声認識などを行なうとき、その情報を逐一クラウドにアップロードするのは、手間やコストの面だけでなく、プライバシーの面でも問題が多い。

また、使い勝手の面でも「反応速度」が大きな課題となる。

クラウドで処理する場合にはより大きな演算リソースを活用できるものの、データを転送する時間+処理速度の分、待ち時間が発生する。

待ち時間は短いほど快適になる。

特に音声認識・画像認知を中心とした処理の場合、コミュニケーションを円滑化するためにも、処理遅延は数十分の1秒単位であることが求められる。音声のノイズ除去や動画の「背景ぼかし」など、ビデオ会議で使われる機能はその最たるものだ。

現在もそのほとんどはローカルデバイス内で処理されているが、今後もニーズはどんどん大きくなっていくだろう。「音声ノイズ除去」に限って言えば、すでに最新のノートPCの場合、大手メーカー製であれば標準搭載といっていいレベルになってきているし、ZoomやMicrosoft Teams自体が、AIを使った音声ノイズ除去機能を持っている。どれももちろん、ローカルデバイスで処理されているものだ。

ただこの種の機能は、現状CPUやGPUを活用することが多く、消費電力や処理負荷が若干上がる。

そこで、プロセッサに「NPU」を搭載し、そちらを活用する流れとなりつつある。ただNPUの搭載については、スマートフォン向けプロセッサが先行していた。主にカメラ機能や音声認識のためだ。

アップルの「Aシリーズ」はその最たるものだが、QualcommのSnapdragonも同様。Googleの「Tensor G」シリーズに至っては、純粋なCPU性能は絞った上でAI処理に特化したコアを強化している。他社に比べ純粋な性能では劣るが、「AI処理が目立つのでとてもコスパがいい」プロセッサであることをアピールしている。

そして、今回のインテルのCore Ultraにより、NPU活用はPCでもトレンドとなったわけだ。

PCで広がるNPU活用

マイクロソフトはWindows 11に「Windows Studio Effect」という、カメラの背景ぼかしや音声ノイズ除去などの機能を搭載してきた。

ただこちらを使うにはNPUが必須であり、CPU/GPUだけでは使えない。

マイクロソフトが11月に発売した「Surface Laptop Studio 2」は、Core Ultra発表前の製品ではあるが、インテルの独立型NPUである「Movidius 3700VC VPU」が搭載されている。理由はもちろん、Windows Studio Effectを使うためだ。

Core UltraにNPUが標準搭載されるのもこの流れの中にある。外付けではないのでコスト面でも消費電力の点でも有利になる。

Core Ultraは2024年初めにも、機械学習(AI)用ライブラリである「DirectML」に対応する。従来はDirectMLをGPUで処理していたわけだが、同じソフトをNPU処理に切り替えやすくなるので、処理負荷は下がると予想できる。

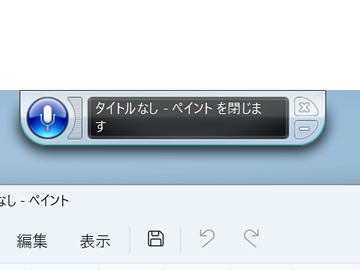

Windows 11上では、音声認識も今後はオンデバイスになっていく。

現状、Windows 11での日本語音声認識は「クラウド処理」になっている。だがマイクロソフトは、クラウド処理による「音声認識」機能を「非推奨」とし、新規開発を凍結すると発表した。今後はオンデバイス処理となる「音声アクセス」機能で代替される。

現状「音声アクセス」は日本語に未対応なので、日本語ではクラウド処理による「音声認識」を当面使うことになるだろう。だが、そう遠くない将来、「音声アクセス」が日本語にも対応し、オンデバイスでより素早い反応を実現していくことだろう。

オンデバイスAIの活用、という面で先を行っているのがMacだ。

最新のmacOS Sonomaでは、Appleシリコン搭載Macの場合、特にソフトを追加することなく、どんなソフトからも、背景ぼかしやノイズ除去(声を分離)が使える。

また、音声認識もNeural Engineでローカル処理されるため反応も早く、特にmacOS Sonomaでは、認識の精度も大幅に向上、使い勝手が増している。

Macの場合、Appleシリコンの中にNPUに類する機能である「Neural Engine」が標準搭載になっているからこのような変化が起きているのだろう。

だとすれば、WindowsでもNPU搭載製品が増えると活用の幅は広がっていくだろうし、PCメーカー・プロセッサメーカーとしても、NPUの活用でPC買い替えの機運を醸成したい……ということになる。

現在「AI PC」としてキャンペーンが始まっているところからも、各社の期待の程がうかがえる。

生成AIにはまだ「GPU」が必要

ただし、ここまでオンデバイスで動くものとして挙げたのは「AI」であって「生成AI」ではない。

実のところ、一般的なAIも生成AIも、核となる処理そのものは非常に近い。

ただ、学習したデータ量や処理負荷が大きく異なるし、使われ方も同じではない。

多くの人が「生成AI」という言葉から期待するような「賢い反応」「精緻な画像を生成する」といった処理を行なうには、GPUやCPUとの組み合わせが必要だし、さらにはGPUから広大なメモリーにアクセスできた方が良い。

要は生成AIが使うLLM(大規模言語モデル)のモデルサイズが大きく、それを処理する性能があった方がいい……ということになるわけだ。

ただ、本当に高性能なGPUが必須になるのは「学習」の方であり、日常的な処理に使う「推論」なら規模を小さくしていくことはできる。また最近は、デバイス内で生成AIを動かすことを想定し、パラメータ規模の小さなモデルを用意する場合が増えている。

Metaの「Llama 2」にも、先日Googleが発表した「Bard」にも、NTTが開発した国産生成である「Tsuzumi」にもオンデバイスを意識した小規模モデルがあり、さらにマイクロソフトも、独自に「Phi-2」という小規模なモデルを作っている。

小規模な生成AIはどうしても「賢さ」には制約がかかるものの、学習内容を特化させていくことで「特定用途向け」にしていくことができる。NPUだけで動かすのは難しいだろうが、CPU・GPU・NPUを組み合わせて価値を出すこともできるだろう。Core Ultraも、生成AIレベルになるとNPUだけでなく、GPUもセットで使う前提になっている。

「生成AIをローカルで動かす」キラーアプリはなにか

ただ最大の問題は、「ローカルで生成AIを動かした場合、明確に価値が高まる用途はなにか」がまだ見えていないことだ。

賢さを求める用途だと、現状はまだクラウドで動かした方がいい。また創作目的などで、学習内容や出力に「制限をかけない」使い方をしたい場合は増えてくると予想されるが、その場合には、高性能なGPU+巨大なメモリーの組み合わせで、大きなモデルを動かした方が、利用者としての満足度は高いだろう。

オンデバイスで効率的に動くサイズの生成AIでなにをしてもらうといいのだろうか?

各社の発表を見ても、まだイマイチはっきりしない。

クラウドではなんとなく見えてきた。

例えばパーソナルな要素に関しては、GoogleのBardがGmailやYouTubeとの連携に対応したため、「個人のアシスタントになった」時の姿がかなり明確にわかるようになってきた。日本語でも、メールの中から特定のものを問いかけてピックアップしたり、YouTube動画で話されている内容を要約したりできるようになり、かなり便利だ。まだまだ的外れな回答もしてくるので過大な期待は禁物だが。

Bardとの連携は、GmailやYouTubeがGoogleのクラウドサービスであり、持ち主の許諾のもとにBardが内容を読み取る(Googleが内容を読んでいる、とは違う点に注意)ことで実現されている。

同じことをローカルでやるとよりプライバシー面では安心なのだが、大量の情報をローカルデバイス内に蓄積している人は意外と少ない。

マイクロソフトがCopilotをまず大企業向けとしたのも、「生成AIの力は大量のデータとともに活用される」特性があり、個人では不利な部分もあるためと推察できる。

現状、Windows 11に搭載されている「Copilot in Windows」も、ブラウザ経由で使える「Copilot」に機能がかなり近く、クラウドと連携して動作している。

今後OSとの統合が進むなら、それはオンデバイスになり、PC内の個人的なデータやPCの活用履歴を生かす形になる可能性はある。PC各社が期待しているのは、そこでよりプロセッサへの依存度が高まり、新しいPCが売れるようになることだろう、とは思う。

ただ、そこでのキラーアプリケーションはまだ見えている状況ではないのも事実。これはスマホにおける「オンデバイス生成AI」も同様だ。

アップルはiOS 17.2で「ジャーナル」という機能を搭載した。これは簡単に言えば「日記を簡単に書く機能」だ。

とはいえただのエディタではない。

iPhone内で写真を撮ったことや音楽の再生履歴、移動履歴などをAIが「オンデバイスで」処理し、「こんなことを書いてみませんか」と利用者側に提案するようになっている。

ジャーナルは「日記」という性質上、個人的な内容を含む場合が多い。アップルはそれをクラウドで処理したくなかったのだろう。ちょっぴり生成AI風味の使い方ではある。

ただ、「提案」してくれるだけなので、もう一声「ジャーナルを書くのを楽しくする仕組み」は必要かと思う。そしてさらに言えば、100人が100人使う機能というわけでもない。

BardのGmail連携やiOS 17.2のジャーナルには、「個人が生成AIをアシスタントとして使う未来にあるべき機能」の片鱗があるものの、まだまだ成熟が足りないし、オンデバイスAIの価値を生かすところまでは届いていない。

生成AIイヤーの続きとして、2024年にはそうした「個人の生活をわかりやすく変える機能」が、オンデバイスで動くものとして登場することも期待している。