西田宗千佳のイマトミライ

第234回

GPUからの脱却と「AI半導体」の可能性

2024年3月4日 08:20

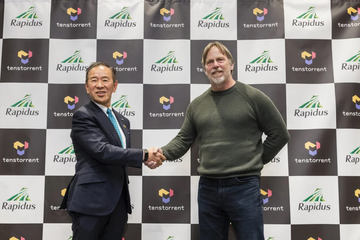

2月27日、先端半導体の開発を目指すRapidus(ラピダス)は、AI関連プロセッサーを開発する米Tenstorrent Holdings(テンストレント)との協業について、東京都内で会見を行なった。会見には、Rapidus・代表取締役社長の小池淳義氏と、Tenstorrentのジム・ケラーCEOが登壇し、狙いを説明した。

現在、さまざまな場所でAIのニーズが拡大している。2023年の「生成AIブーム」もあり、ニーズだけでなく、処理負荷もどんどん増えている状況だ。

当然ながら、RapidusとTenstorrentの動きも、今後さらにAIのニーズが高まることを受けてのものであり、現在での「勝ち組」であるNVIDIAを意識してのものでもある。

AIとプロセッサーの関係は今、どうなってきているのだろうか。Rapidus・Tenstorrentの発表を軸に考えてみよう。

GPUよりも有利な「AI半導体」の競争が激化

「AIが抱える課題は消費電力」

Rapidus・小池社長の主張はシンプルだが説得力がある。

GPUを中心としたAI処理の負荷、中でもデータセンター向けの処理ニーズは急激に高まっている。その分消費電力が上がるわけだが、そのことは、社会全体にとって大きな負担になる。

そのため、各社が「AI特化型プロセッサー」を開発し、GPUからの脱却を目指そうとしている。

その1つがTenstorrentだ。その狙いは以下の記事に詳しい。

プロセッサーの歴史に詳しい方には説明不要だが、ケラー氏は半導体業界のレジェンドと言える開発者の一人。AMDの「Athlon」に開発に関わり、アップルでA4からA7までを開発して「Appleシリコン」の基礎を作り、その後にまたAMDで「Zen」アーキテクチャを作った。彼が関わった技術は幅広い領域に広がっており、普段意識することはないが、誰もが一度は採用製品を使っている……というレベルである。

彼がAIプロセッサーを目指すのは、簡単に言えば「GPUはAIに最適な存在ではない」と考えられているからだ。

GPUは本来グラフィック処理のために作られたプロセッサーだ。いわゆるCGを中心としたグラフィック処理は大量の行列演算を必要とする。それを並列かつ高速に行なうことが求められる。

その特性が、同様に多数の行列演算を必要とする用途にも使われた。その一つが仮想通貨のマイニングであり、AIの学習や推論である。

ただ、AIの処理は並列処理というよりも、処理結果が次々と他の演算に影響を与える「フロー」的な構造になっている。

GPUは「演算をする」という意味ではAIに向いていても、構造として最適というわけではない。一方でニーズは拡大傾向にあり、その波に乗ってNVIDIAの評価はうなぎ登りだ。

そこに割って入ることができれば、ビジネスチャンスも価値も大きい。だから前述のように、多くの企業がAI向けのプロセッサー開発に力を入れているわけだ。

例えばマイクロソフトも、昨年秋に独自のAIアクセラレータチップ「Azure Maia」を発表している。

Tenstorrentを含め、多くの企業が「AI向けプロセッサー」の開発に着手している最中なのだが、Tenstorrentの場合、半導体の製造パートナーとしてTSMC・サムスンに続いて提携するのがRapidus、ということになる。

エッジAIで組むラピダスとテンストレント

RapidusとTenstorrentはどんなプロセッサーを作るのか?

実は、サーバー向けを主軸にするわけではない。今回彼らが提携したのは「エッジAI向け」のプロセッサーである。

現状、負荷の大きいAIはクラウドの向こうにあるサーバー上で処理が行なわれている。

今後AIのニーズが高まれば高まるほど、処理する内容は多様になっていく。音声認識や画像認識は様々な機器に内蔵されるようになっていき、生成AIを生かした「対話型AI」も増えるだろう。それら人と関わりあうAIが増加していくことになると、AIに求められる要素も変わっていく。

データをすべてクラウドにアップロードするのは、処理時間の点でもプライバシー対策の面でもマイナスだ。機器の中でAI処理が完結する「エッジAI」のニーズがより高まっていく。

この辺りは多くの企業が目指す一般的な方向性である。昨年末、インテルが「Core Ultra」シリーズにエッジAI用のNPUを内蔵、マイクロソフトと組んで「AI PC」をアピールし始めたのもこの流れである。

そして、エッジAIを各機器に搭載することになると、より消費電力への要求も厳しくなる。Rapidusは2nmプロセスの半導体製造を目指しており、より消費電力は下がる。Rapidusは会見で以下のようなグラフも示した。

ただしこのグラフは、現在GPUに使われているプロセスよりもかなり古いものまで含めて作られており、現実問題として、プロセスの進化だけで100倍もの劇的な変化が起こるわけではない。その辺はご注意いただきたい。

それ以上に彼らが打ち出すのは「柔軟性とスピード」だ。

Rapidus・小池社長は、「日本は応用が得意であり、AIもそちらを軸に展開できるのでは」と説明する。PCなどの汎用機器向けというより、自動車や家電、いわゆるIoT機器など、幅広いニーズを目指したものになるだろう。

コアなものから色々な用途に応じて最適化したチップを作るという狙いだ。そのためには、設計自体を導入企業からのニーズに合わせて素早く最適化していくことが必要となる。

そうしたプロセスを、同社は「RUMS(Rapid and Unified Manufacturing Service)」と呼び、半導体製造事業者としての差別化点にしようとしている。

今回、RapidusとTenstorrentが提携して開発していくのは、エッジAI向けプロセッサーのコア技術になる。

経済産業省の支援を受けて「技術研究組合最先端半導体技術センター(LSTC)」が立ち上がっており、まずここで2nmプロセスおよびその先に向けた半導体の開発が行なわれる。

LSTCでのプロジェクトの1つが「2nm世代半導体技術によるエッジAIアクセラレータの開発」であり、まさに今回の提携に関わるものとなる。

新チップは5年後、NVIDIAは通信にも

他方、RapidusとTenstorrentが関わるエッジAIプロセッサーが完成し、実際に市場に出てくるのは2020年代後半。まだ4、5年は時間がかかる。

現実的な話をすれば、短期的にはAI処理はGPUが主力となるだろうし、エッジAI向けプロセッサーの強化もじわじわと進んでいくことになるだろう。

AI向けのプロセッサー競争で、NVIDIAは追い立てられる状況にある。だが、彼らももちろん、ニーズ拡大や立場の強化を考えている。

2月26日には、「AI-RANアライアンス」という団体の設立が発表された。

これは、無線アクセスネットワーク(RAN)でのAI活用を進める団体だ。

携帯電話事業者の電力消費量は向上し続けているが、その大半は基地局消費だ。不要な場所・時間に出力をコントロールし、消費電力を下げつつ、必要な部分での出力を上げるという処理が必須だが、そこではAIが活躍する。

また、基地局にエッジAIサーバーを設置してサービスでの活用を目指す流れもあるが、どのくらいの粒度でどう使うと効率的かの検証も必要だ。

このアライアンスには、ソフトバンクをはじめとした携帯電話事業者はもちろん、マイクロソフトやAWSのようなクラウドインフラ事業者、そしてNVIDIAも参加する。

そうして新しいニーズを開拓し、ライバルが追いつく前に振り切ろうというのもまた、NVIDIAの戦略なのだろう。

いきなり常識を覆す「発見」が生まれる可能性も

一方で、生成AI技術の大転換によって、演算コストが劇的に変わる可能性もある。

2月27日、マイクロソフトは「The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bits」という論文を公開した。

The Era of 1-bit LLMs: All Large Language Models are in 1.58 Bits

この技術は、俗に「量子化」と呼ばれる手法に関するもの。大規模言語モデル(LLM)のパラメータを「0」「1」「-1」で表すことで、計算を簡略化する技術だ。

結果だけを言えば、従来必要だった「行列の掛け算」が「シンプルな行列の足し算」となり、演算負荷もメモリー使用量も劇的に下がる。本当にこれでLLMとしての性能が変わらないのだとすれば、確かに画期的な技術だ。生成AIにまつわるコストやエネルギー消費についても常識が変わる。もちろん、GPUかAI専用チップかという議論にも影響してくる。

とはいうものの、この論文はまだ技術評価が始まったばかりで、効果検証が終わったわけではない。論文自体も短く、その内容だけで判断するのは難しい。だからニュースだけを見て「これでGPUが不要に」と断言してしまうのは、ちょっと騒ぎすぎだ。

ただ、仮にこの論文がそこまで価値のないものと結論づけられたとしても、「突然すべてをひっくり返しかねない技術が出てくるかもしれない」という現象自体には注目しておく必要がある。

AIには予算と研究者が集中しているからこそ、半導体もロジックも急速に進化していくのだ。