トピック

Grokの性的画像加工とディープフェイクで起きる「卒アル問題」

2026年1月29日 08:20

Xが提供するAI「Grok」で実在の人物画像が性的な画像に加工される被害について、米英の非営利団体「デジタルヘイト対策センター(CCDH)」は1月22日、子どもを描写していると思われる23,000枚を含む約300万枚の性的画像を生成したとの推定を発表しました。

これは、Grokが画像からワンクリックで編集できる機能を搭載した直後の25年12月29日から1月8日までの11日間についての調査です。著名な女性や女子児童が水着や透明テープのみを身に着けた姿に加工されていたとの報告がされています。

Xに投稿されている画像をワンクリックでAI加工できる機能は12月24日頃からリリースされ、日本でも物議を醸しました。これまでも、他人が投稿した画像をGrokで加工することは可能でしたが、ブラウザ版の本機能では投稿画面から手軽にGrokでの加工ができます。

リリース当初から「悪用」や「著作権侵害」を懸念する声は上がっていましたが、その懸念は的中しました。公開からわずか1カ月の間に、性的な画像加工が爆発的に急増したのです。

こうした事態に、イギリス政府やイギリス規制当局(Ofcom)が批判し、マレーシアとインドネシアはGrokへのアクセス遮断に踏み切りました。日本政府も1月16日、X社に改善を要請したと発表しています。要請は9日に実施したとのことです。

こうした批判を受け、1月15日にXは声明を発表し、ビキニなどの露出度の高い服装をした実在の人物の画像の編集を全世界的に禁止するための技術的対策を実施したと発表しました。この制限は、有料会員を含むすべてのユーザーに適用されます。

— Safety (@Safety)January 14, 2026

しかし、Grokの開発元であるxAIが提供するGrokのスタンドアロン版では、いまだに同様の加工ができるため、問題は完全に解決したとは言い難い状況です。

Xは元々、性的な画像自体を禁止しているのではなく、「児童の性的搾取」、「合意のないヌード」、「望まれない性的コンテンツ」を規制しています。他のサービスでは見られないような性的画像があるのはそうした理由です。

しかし、本人の同意のもとで投稿される「表現の自由」にあたる性的な画像と、本人の同意がないままAIで服を脱がせたり性的なポーズをさせたりする「性的ディープフェイク」は別の話です。この境界線が曖昧なことに加え、Grokが誰でも手軽に悪意を実行できる機能を用意したことで事態が深刻化しています。

1月20日には、生成AIで女性芸能人の画像を性的ディープフェイクでわいせつな画像を作成した男が、わいせつ電磁的記録媒体陳列の疑いで逮捕されています。Xで起きた事件ではありませんが、生成AIの性的ディープフェイクが罪に問われた事例として重要な事件です。

1月26日には、欧州委員会がGrokの性的画像生成問題でXを正式調査することを発表。今後、Xに対する聞き取り調査、立入検査を実施し、Xのサービスに改善が見られない場合には暫定措置を命じる可能性があります。

性的ディープフェイクで起きる「卒アル問題」

性的ディープフェイクの被害は中高生にも及んでいます。しかも、同級生による加害も多いのです。

警察庁は生成AIなどを悪用して児童(18歳未満)の性的画像を作成した事案の被害相談について、25年1月~9月に約80件の相談が寄せられ、被害者の8割超が中高生だったと発表しています。また、加害者の半数が同級生や同じ学校の生徒だとわかっています。

加害事例には、女子生徒がSNSに投稿した画像を生成AIで裸体にした男子中学生、学校のタブレット端末から見られる行事アルバムから女子生徒の画像を保存して生成AIで性的な画像を生成した男子中学生などがあります。生成した画像はグループ内での共有に限らず、掲示板への投稿や同級生に販売されたケースもありました。

以前から、卒業アルバムの画像を性的に加工する「卒業アルバム問題(卒アル問題)」は問題視されていましたが、生成AIの精度向上により、気軽な性的ディープフェイクが可能になっている現状があります。SNSへの投稿を控えたとしても、卒業アルバムや行事の写真から性的ディープフェイクを行なわれてしまうと、被害を防ぎようがありません。

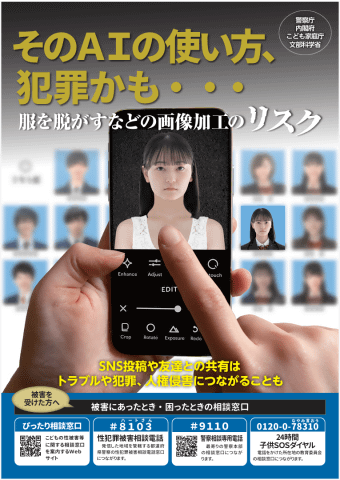

警察庁などの省庁は、性的ディープフェイクについての啓発活動を開始しています。パンフレットには、生成AIで他人の画像を加工し、SNSで公開している事例が紹介されています。

性的ディープフェイクを作成、公開する行為は名誉毀損罪、わいせつ物頒布等罪、わいせつ電磁的記録公然陳列罪、著作権法違反、児童ポルノ禁止法違反などに問われる可能性があります。

簡単だからといって気軽に作成していいものではありません。スマホやタブレットを使える人なら誰でも加害者になるかもしれないため、もし周囲のお子さんが生成AIに興味を持っているようなら、生成する画像について一度話し合っておくことをおすすめします。

ディープフェイクは選挙にも影響

ここでは性的ディープフェイクに焦点を当てて紹介しましたが、もちろん性的ではないディープフェイクも問題です。特に2月8日に行なわれる衆議院選挙に関連して、立候補者に関するディープフェイクがSNSにあふれることが懸念されます。

25年6月3日に行なわれた韓国大統領選では、AIで生成されたディープフェイクの拡散が問題となり、中央選挙管理委員会が計1万件以上の削除要請をしたとの報道もあります。SNSでは候補者が刑務所に入っているような動画や殴り合っている動画など、ディープフェイク動画があふれており、選挙管理委員会が対策チームを作って削除などの対応に追われました。

総務省は1月23日、X、Meta、Googleなどの大手SNS事業者に対し、選挙に関する偽情報の迅速な削除を正式に要請しています。筆者がTikTokやXなどを見たところ、政治家に関するディープフェイクはAIで作ったとわかる動画が多かったのですが、実在の画像に偽・誤情報をつけて投稿されているケースもありました。偽・誤情報は続々と投稿されているため、全てに対応することは難しいでしょう。

SNSにディープフェイクや偽・誤情報があふれるようになった今、私たちはどうしたらいいのでしょうか。個人の力では、SNSに流れてくる画像や動画が本物なのか生成AIで作られたフェイクなのか、判断が難しいケースもたくさんあります。まずは「自分も騙されてしまうかも」と考えて、複数の情報源をあたるなどの検証をするように心がけたいものです。検証を続けていくことで、偽・誤情報に騙されずに済むかもしれません。

また、ディープフェイクを目にしたとき、反射的に拡散しないことも大切です。できればプラットフォームに「報告」して削除を依頼するなど、被害を拡大させない行動ができると理想的ですが、「何もしない(広めない)」だけでも、十分に価値のある行動だと思います。