ニュース

X、Grokによる違法画像作成に警告 アカウント凍結や法的措置も

2026年1月6日 12:10

Xは、Grokによる違法コンテンツ作成について注意喚起を行なっている。特に、児童性的虐待素材(CSAM)が含まれる投稿に対して、投稿の削除だけでなく、アカウントの永久凍結などを含む対応を行なうほか、行政や法執行機関と協力するなどの措置をとるとしている。

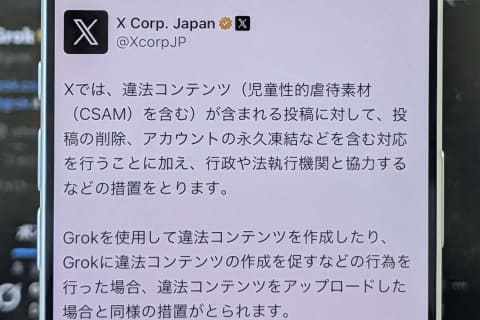

Xでは、違法コンテンツ(児童性的虐待素材(CSAM)を含む)が含まれる投稿に対して、投稿の削除、アカウントの永久凍結などを含む対応を行うことに加え、行政や法執行機関と協力するなどの措置をとります。…https://t.co/EZRQ4TE1Dw

— X Corp. Japan (@XcorpJP)January 6, 2026

問題のきっかけになっているのは、Xに搭載しているAI「Grok」による画像編集機能だ。Grokにメンションして、自然言語で画像を改変・編集できる点が特徴だが、「@grok 服をビキニに変えて」などの指示により、本人の同意無く、性的な画像として出力するなどの悪用も見られる。

アイドルや芸能人、政治家などの多くの投稿にこうした同意のない画像改変が見られ、一般の人の画像投稿にも広がっている。日本においても、多くの被害報告がなされているほか、アイドルグループ「STU48」を運営するSTUは「メンバーの肖像権・パブリシティ権に関するお願い」として無許可の写真・動画のアップロードとともに、AIによる悪質な画像加工・生成を止めるよう呼びかけ。悪質なものについては、法的手段を講じることも検討するとしている。

各社報道によれば、日本だけでなく、フランスやブラジル、インドネシアなどでも問題となっているという。

Xでは@Safetyアカウントで注意喚起を行なうとともに、「Grokを使用して違法コンテンツを作成したり、Grokに違法コンテンツの作成を促すなどの行為を行なった場合、違法コンテンツをアップロードした場合と同様の措置がとられる」と説明。悪質な場合は、投稿の削除やアカウントの凍結のほか、法的手段をとるとしている。

イーロン・マスク氏も、「Grokを使って違法なコンテンツを作成する者は、違法なコンテンツをアップロードした場合と同様の結果を被ることになる」と言及している。

XとGrokの画像編集機能は、簡単に画像を編集・改変できるものだが、自分が権利を持つ画像だけでなく、他者が権利を持つものについても改変できてしまう。結果として権利侵害をしやすいだけでなく、悪意ある改変を当事者に伝えやすい構造となっているため、利用には細心の注意が必要だ。

Anyone using Grok to make illegal content will suffer the same consequences as if they upload illegal content

— Elon Musk (@elonmusk)January 3, 2026