ニュース

すべてのGoogleサービスと世界に浸透する「Gemini」 Google I/O 2025

2025年5月21日 14:39

Googleは20日(米国時間)、開発者会議「Google I/O 2025」を開催し、Geminiを中心とした取り組みを紹介した。Geminiの最新モデルや、動画や画像の展開のほか、Gemini Liveなどによる個人向けのAIエージェント、Android XR展開、AI検索などについて発表した。

ここではGoogle I/Oの主要な発表をまとめて紹介する。

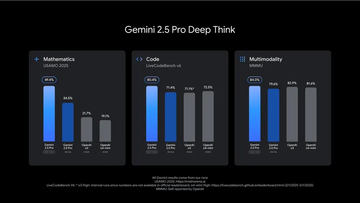

GoogleとAlphabetのスンダー・ピチャイCEOは、AIへの取り組みを軸に説明。Gemini 2.5 Proが主要なベンチマークにおいてトップになっていることや、モデル進化を支えるGoogleのインフラスの強みなどに言及した。第7世代TPUのIronwoodは、前世代と比較して10倍のパフォーマンスを実現しており、こうしたインフラの強みがあるからこそ、モデルの価格を削減しながら、高速なモデルを提供できているという。

24年には、Googleの製品とAPI全体で月間9.7兆のトークンを処理していたが、現在は50倍以上の480兆トークンを超えており、700万人以上の開発者がGeminiを使って開発している。これは昨年の5倍で、Vertex AIにおける Gemini利用は40倍に増加している。

Geminiアプリの月間アクティブユーザー数は4億人以上。特に2.5 シリーズのモデルにおいて、成長と利用の活発化が見られているという。

Gemini 2.5やGeminiアプリの最新機能

AIモデルのGeminiでは、「Gemini 2.5 Pro」の最新機能を発表した。2.5 Flashがアップデートにより進化したほか、Gemini 2.5 Pro向けの強化推論モード「Deep Think」なども追加する。また、ネイティブ音声出力やコンピュータ利用、MCP対応なども行なわれる。

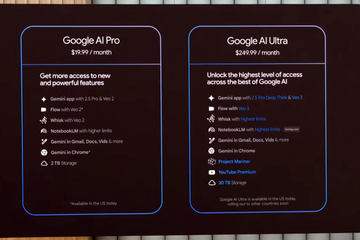

Geminiアプリでは、Gemini Liveのカメラと画面共有機能をAndroidとiOSで無料で提供するほか、新たな画像生成「Imagen 4」、動画生成「Veo 3」などを導入。また、AIサブスクリプションプランとして、2,900円の「Google AI Pro」と249.99ドル(約3.6万円)の「Google AI Ultra」も展開する(Ultraは米国のみ)。

メディア生成モデルは、動画生成の「Veo 3」と画像生成「Imagen 4」のほか、映像製作用ツール「Flow]を発表。プロンプトで短いストーリーを伝えるだけで、その内容を鮮明に表現した映像を生成できるだけでなく、AIを使った高度な映像制作に対応する。

研究開発から製品へ「Google Beam」 Meetで翻訳

Googleが進めてきたAI研究は実際の製品に実装されるフェーズに入ってきた。

その一例が、「Google Beam」だ。数年前のGoogle I/Oで発表した3D動画技術である「Project Starline」を製品化する。

Project Starlineでは、「離れていても、まるで同じ部屋にいるかのような体験」を目指していたが、今回ビデオ通信プラットフォーム「Googel Beam」を発表。AIを中核に据え、2Dビデオストリームを臨場感あふれる3D体験に変換して表示する。

6台のカメラとAIを使ってビデオ ストリームを結合し、3Dライトフィールド ディスプレイにレンダリング。ミリ単位でのヘッド トラッキングを、毎秒60フレームでリアルタイムに実行することで、自然で没入感のある会話体験が実現できるという。HPと協力し、初のGoogle Beamデバイスを25年後半に一部の顧客向けに提供予定。

また、Google Meetに音声翻訳機能を近日導入。ほぼリアルタイムで、話者の声やトーン、表情まで一致させ、言語を超えた自然で流暢な会話を可能とする。

英語とスペイン語の翻訳機能は、Google AI ProとUltra のユーザー向けにベータ版として提供を開始。今後数週間以内にさらに多くの言語を追加予定としている。Workspace のビジネスユーザーには、25年中に早期テストとして提供予定。

Project Astra、ほぼ「Gemini Live」に内蔵 エージェントも

また、24年に発表した「Project Astra」も「Gemini Live」により製品化。カメラと画面共有機能をGemini Liveに組み込み、面接の準備からマラソンのトレーニングなどで活用されている。

Androidユーザー向けにはすでに提供されているが、20日からはiOSユーザーにも提供開始する。

24年12月に発表した、WebブラウザがAIエージェントになる「Project Mariner」も順次強化しており、様々なサービスに応用されている。ブラウザを起点に、人間とエージェントの相互作用の未来を探る研究で、同時に異なるタスクを処理できるエージェント システムが搭載されている。これにより、情報の検索、予約、ショッピング、調査など、さまざまな作業を同時に進められる。

Project Marinerは、Chrome、Google 検索、Gemini アプリへのエージェント機能の導入が進められており、Gemini アプリの新たな Agent Modeでは、賃貸物件を探している場合、Zillowなどのウェブサイトで条件に合った物件を見つけたり、フィルターを調整したり、MCPを使って物件情報にアクセスして、内見の予約といった活用をサポート。近日中にGoogle AI Ultraの一部ユーザー(米国)向けに提供する。

このようにWebのエコシステムをAIエージェントで活用していく取り組みを進めている。

AIによるパーソナライズ 検索もAI

また、Google サービスにおいてパーソナライズを強化していく。Geminiは、ユーザーの許可と管理のもと、Google アプリ全体で関連するパーソナル コンテキストを利用可能にする。

一例が、Gmail の新しいパーソナライズされた「Smart Replies」。たとえば友人から、以前に行ったことのある旅行先についてアドバイスを求めるメールが届いた場合、Geminiはユーザーの過去のメールや、Google ドキュメントで作成した旅程などのGoogle ドライブ上のファイルを検索し、的確な返信を提案する。普段のユーザーの挨拶やトーン、スタイル、よく使う言葉までをあわせて、適切で“あなたらしい”返信を生成するという。パーソナライズされたSmart Replies は、25年後半に一部ユーザー向けに提供開始予定。

Google 検索も「AIモード」を米国で本格展開する。AIモードでは、質問をサブトピックに分解し、複数のクエリを同時に実行。これにより、従来のGoogle 検索よりもウェブをより深く探索し、質問にあった関連性の高いコンテンツを発見できる。

さらに、数百の検索を実行し、多様な情報を横断的に分析、専門家レベルの引用付きレポートを数分で生成できる「Deep Search」も展開する。