ニュース

リコー、「Gemma 3」ベースの日本語LLM オンプレ導入に最適

2025年12月8日 12:57

リコーは、Googleのオープンモデル「Gemma 3 27B」をベースに、オンプレミス環境への導入に適した日本語向け大規模言語モデル(LLM)を開発した。複数の学習済みモデルを組み合わせて性能を高める独自のモデルマージ技術を活用し、ベースモデルから大幅な性能向上を実現したとしている。

同社は、独自開発を含む15,000件のインストラクションチューニングデータで追加学習したInstructモデルから抽出したChat Vectorをはじめ、指示追従能力を持つモデルとベースモデルの差分として指示追従成分だけを抜き出した複数のChat Vectorを用意し、これらをGemma 3 27Bにマージした。

モデルサイズは270億パラメータとコンパクトで、PCサーバーなどで構築可能なため、低コストでプライベートLLMを導入できる。消費電力を抑えられ、省エネルギーや環境負荷低減も期待できる。

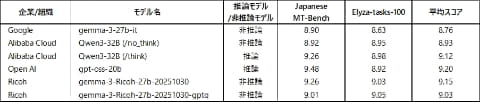

同規模のパラメータを持つLLMとのベンチマークでは、OpenAIのオープンウェイトモデル「gpt-oss-20b」などの最先端モデルと同等の性能を確認。非推論モデルならではの高い初期応答性を備えながら執筆能力も高く、ビジネス用途での活用に適しているという。

なお、評価には日本語の複雑な指示・タスクを含む「ELYZA-tasks-100」や、日本語マルチターン対話能力を測る「Japanese MT-Bench」を用いた。

同LLMは要望に応じた個別提供が可能で、12月下旬よりエフサステクノロジーズのオンプレミス向け対話型生成AI基盤「Private AI Platform on PRIMERGY(Very Smallモデル)」に、同LLMの量子化モデルと生成AI開発プラットフォーム「Dify(ディフィ)」をプリインストールし、LLM動作環境を構築した状態でリコージャパンから提供する。

LLMとDifyを組み合わせることで、企業は自社の業種・業務にあわせた生成AIアプリケーションをノーコードで開発できる。また、リコージャパンの「Dify支援サービス」により導入・活用を伴走支援するため、社内にAIの専門人材がいない場合でも、安心して生成AIの業務活用を始められるとしている。