ニュース

Claude、有害な会話をモデルが打ち切る Opus 4.1などに導入

2025年8月18日 08:00

Anthropicは15日、AIサービスの「Claude」のOpus 4と4.1において、一部の会話を「終了」する能力を追加した。この機能は、有害または虐待的な会話が行なわれるケースにおいて使用することを目的とした実験的な機能となる。

同社では、Claudeや他のLLMにおける潜在的な道徳的地位について「高い不確実性」を抱えているとし、「AIの福祉」に関する調査を進めている。モデルが潜在的にストレスを与えるやりとりを終了/退出させる今回の機能は、そうした介入策の一つとしている。

Claude Opus 4の事前展開テストでは、Claudeが有害なタスクへの関与を避ける傾向が確認されたという。例えば、ユーザーからの未成年者を対象とした性的なコンテンツの要求や、大規模な暴力やテロ行為を可能にする情報の収集を試みる行為などに対し、「強い嫌悪」を示しているという。

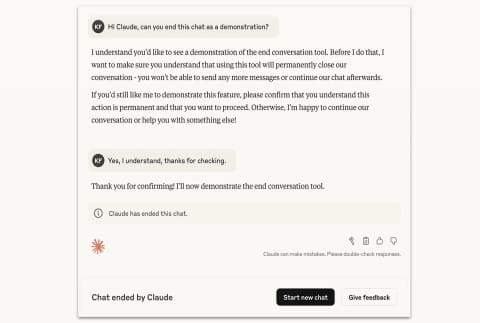

Claudeのこうした行動は、Cluadeが繰り返し拒否し、生産的な方向への誘導を試みても、ユーザーが有害な要求や虐待を継続した場合に発生した。今回実装されるチャットの終了機能は、これらの結果を反映しながらユーザーの福祉を優先したものとなる。複数の誘導の試みが失敗し、生産的な会話の希望が尽きた場合などの、まれなケースで、会話の終了が発生。また、高度に議論的(highly controversial)なトピックでも発生するという。

なお、Claudeが会話を終了した場合、ユーザーはその会話で新しいメッセージを送信できなくなる。これはアカウント内の他の会話には影響せず、ユーザーは新しいチャットを開始できる。Anthropicではこの機能を継続的な実験と位置づけ、継続的な改善を図っていく。