西田宗千佳のイマトミライ

第312回

Windows 11、AIエージェントになる キーボード・マウス・AIとその先の競争

2025年10月20日 08:20

10月16日、マイクロソフトは、Windows 11のAI強化について発表した。

アップデートは随時行なわれ、マイクロソフトは「すべてのWindows 11搭載PCをAI PCにする」としている。これはWindows 11に対する本格的なテコ入れであるのと同時に、PCでのAI利用についての方向性を示唆するものとも言える。

そして、内容をよく分析すると、それは「個人のアシスタントとしてのAI」の可能性を考える上で、重要な要素にもなってくる。

それはどういうことなのか? 今回はその点を考えていきたい。

Copilot VisionでPCに「3つ目のUI」を

今回の変更はどのようなものなのか?

それを知るには次のビデオを見るのがわかりやすい。

このビデオでは、利用者がCopilotと対話しながらPCを使っている。そして、「タイプ」「クリック」に続くもう1つのUIとして「会話」をアピールしているのもわかる。

といっても、音声でPCやスマホを操作する、という話は別に新しいものでもない。そして、「音声でアプリを起動する」程度ではさほど便利にはならない、ということも、みなさんよくお分かりのはずだ。

それでも今回、マイクロソフトが「音声」をキーワードにしたのは、アプリを起動したり、文字を音声で入力したりする程度の使い方ではないから、ではある。

今回のアップデートで軸となるのは「Copilot Vision」というAIエージェントだ。

この技術は簡単に言えば、利用者が見ているPCの画面をAIも一緒に見て、その中になにが映っているのかを理解する。結果として、内容に応じて返答することができる。

ビデオの中では「画面に表示されているマイクがどのメーカーのもので、どこで買えるか」「表示されている風景がどこのもので、どう節約すればいいか」といった質問に答えているし、そのほかにも、「ハイレゾロスレス出力のためにはどこの設定を変えればいいのか」という質問にも、操作すべき場所にマーカーを表示しながら回答している。

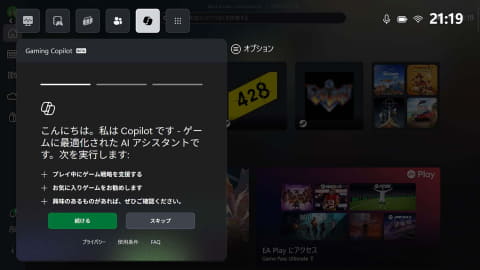

ゲームについても、「Gaming Copilot」という機能が搭載される。音声でCopilotに質問すると、プレイ中のゲームの画面を解析し、「次にどこへいくべきか」「アイテムを取るにはどうすべきか」といったヒントを教えてくれる。

これらの機能で重要なのは、アプリやサービスの側には変更が必要ではない、という点だ。

詳しい人間が画面を見て判断するように、Copilotが画面を見て判断する。マイクロソフトが「すべてのWindows 11 PCをAI PCにする」と言っているのは、特別な対応が不要であることに加え、主なAIの処理はクラウドで行なわれていて、PCの側に特別な機能を必要とするわけではない、という特徴があるから……ということになる。

「人間と同じものをAIが見る」意味とはなにか

AIに働いてもらう上で重要なのは、「AIが判断するための材料をどう与えるのか」ということだ。

人間が必要な作業をするには、自分がなにを見ているのかという情報が必要になる。AIに働かせるには、情報を得るという要素もAIに担当させる必要が出てくる。

AIチャットサービスでは文章を使う。声で命令する場合も、結局は音声をテキスト化して渡す。

それでは情報が足りないことは多い。だから、画像や関連ファイルをアップロードして処理してもらうことになる。

特別なことのように思えるが、実際にはそうでもない。Androidで採用されている「かこって検索」や、iPhoneで採用されている「Visual Intelligence」も、検索に必要な情報として画像を提供し、それを解析して答えを出す。

その先として、作業している内容を「自分と同じように」AIが把握して作業を進める……という考え方があり、Copilot Visionが行なうのはまさにそれだ。

この方法論、PCとは異なるジャンルでも話題になりつつある。

Metaの「Ray-Ban Meta」に代表される、カメラを搭載した「AIグラス」の本質がここにある。自分が見ているものをカメラがAIに伝えてなにかをしてもらう、というのが1つの用途になるからだ。

本当ならば、自分が見ているもの・やっていることの全てをAIが見ていてサポートしてくれる……という姿がある意味で理想である。

だが、見ているものをずっとAIが監視するのはプライバシー上の懸念がある。AIグラスででもCopilot Visionでも、ある種の命令が与えられたら認識する、という形を採っている。

Copilot Visionの場合には「Hey, Copilot」というキーワードがそれに当たる。音声で命令してもいいが、音声以外の場合には「Copilotキー+Cキー」で呼び出す。

スマホでも今後は、Googleが開発している「Project Astra」のような形で、スマホのカメラが捉えた内容・スマホのマイクが捉えた音声でAIが判断し、人間とコラボレーションする機能が広がるだろう。

アップルがApple Intelligenceで本来目指しているのも、「オンデバイスAIによってプライバシーを確保しつつ、自分の行動文脈をAIに理解してもらい、Siriからアプリ内の特定機能だけを呼び出して使う」ような世界である。

各社が目指す方向性は似ているものの、それをどう実装し、どう使わせるかはまだかなり異なる。現在はその初期にあり、各社が試行錯誤の元に実装している段階といえる。

その中で「画面を人間と一緒に見る」という機能を広く提供する、というマイクロソフトの選択は大きい。

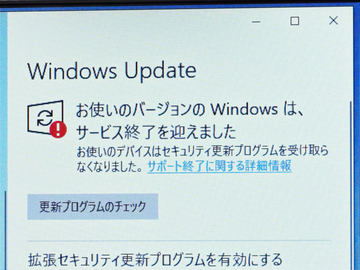

その背景には、Windows 11を差別化するという要素もあるだろう。Copilot VisionはクラウドベースなのでWindows 10にも実装は可能だろう。だが、その後に必要になる機能強化と製品の差別化を考えると、アップデートも終わったWindows 10を切り捨てるのは自然な判断でもある。

「AIが勝手に働く」機能が必須に 激化する競争

ただ、Copilot Visionは本当に役立つのか、毎日使う機能になるのかどうかはわからない。

わからない機能を探す、設定変更方法を教えてもらうには間違いなく便利だろう。

だが、Copilot Visionはあくまで「一緒に画面を見ながらなにかの指南をする」機能であり、実際に動くのは人間の側だ。

その中でどのようなシナリオで使うと便利なのか、ということが明確になっていく必要がある。なんでもできると言いつつ、どこまでのことができるのか、実際に機能を使った結果が見えてこないと、なんとも判断が難しい部分はある。

Copilot Vision自体は2024年5月に発表されており、機能を少しずつ拡張しつつ、今回一般公開になった。だから、その使い道や可能性も「ようやく検証が始まる段階」と考えるのが正しい。

今後マイクロソフトは、さらにAIとの連携を強化するために「Copilot Actions」を導入する。

これは「CopilotがPCの中で、自分の代わりに作業をやってくれる」もの。多くの人が考える「AIが代わりになにかをしてくれる」というものに近い。

こうしたことは、ウェブ上のAIサービスとして先に広がり始めている。

「Manus」や「Genspark」などでは、クラウド上にAIが動作するPCのインスタンスが用意され、その中でウェブへのアクセスやファイル生成、コードの生成などの処理を行なう。OpenAIの「Operator」も似たところがある。それぞれ得意なことは異なるが、「クラウドの向こうでAIが、自分のためだけの領域で作業をしてくれる」という点では似ている。命令をすれば勝手に作業をしてくれて、人間はその間に別のことをしていられる。

Copilot Actionsは、PC内で利用者のデータを使って自動作業するものだ。例えば大量の画像ファイルを同じルールにそって加工してもらう場合、命令を出せばあとはCopilot Actionsが作業を行なう。以下のデモ動画でも、「人間は他の作業をしていてもいいし、休んでいてもいい」と語っている。

Copilot Actionsでは、PC内にAIのアカウントを作り、さらにAIだけが作業に使う領域を用意する。直接利用者のアカウント内でファイルを扱わないのは、プライバシーとセキュリティの両面で配慮が必要だからだ。利用者が許可を出した時に働く。

Copilot VisionとCopilot Actionsが連携することが、マイクロソフトの目指す「PCの上でのAI」の姿の1つだろう。そうなれば、キーボード・マウスに続く3つ目のUIとして「AI」という柱が生まれることになるだろう。

そのためにはセキュリティを含めた多数のテストが必要だし、便利な使い方のシナリオも必要になるだろう。

そして同時に、クラウドでAIエージェント・サービスを作る企業とも、他のOSを作る企業とも競争を続けることになる。