西田宗千佳のイマトミライ

第220回

OpenAI「GPTs」がもたらす革命 誰でも「自分のコパイロット」時代へ

2023年11月13日 08:20

11月6日(米国時間)、OpenAIは、同社初の公式イベント「OpenAI DevDay」を開催、生成AIサービス「ChatGPT」に複数の新機能を追加した。基調講演の模様は以下から視聴できる。

中でも驚くべきは「GTPs」という機能が搭載されたことだ。

この機能、簡単に言えば、自分が必要としている「カスタマイズしたChatGPT」を、特別な予備知識なくチャットから作れるものだ。

OpenAIやマイクロソフト、Googleなど多くの企業は、人の作業をサポートする「コパイロット」と呼ばれる機能の開発を進めている。色々なやり方はあるが、OpenAIのGPTsは、その本命の1つとなりうる方向性である。

それはなぜなのか? そして他社が目指すものとどう違うのだろうか? ここで改めて解説してみたい。

GPTsで「オリジナルボット」を作ってみよう

では実際に、GPTを使ったオリジナルチャットボットを作ってみよう。

GPTsはChatGPTの有料プランである「ChatGPT Plus」(月額20ドル)、もしくは企業向けの「ChatGPT Enterprise」向けに公開されている。無料版では利用できない。

作ったチャットボットは公開できるが、使えるのは「ChatGPT Plus」の利用者だけで、無料版利用者は使えない。以下にリンクも紹介するので、自由に試していただきたい。ただし、重ねていうが、「ChatGPT Plus」の利用者しか使えない。

最初に「特定のサイトから知識を得て答える専門家」のチャットボットを作る。僚誌・AV Watchの記事を読み込み、AV機器に関する質問に答えるものだ。

これは簡単。AV Watchのサイトをウェブブラウズ機能で読み込みつつ、質問に答えるように書くだけだ。同時にチャットボットの名前やアイコンまでChatGPTが作ってくれる。なんて親切な。

以下にリンクも紹介するので、自由に試していただきたい(ChatGPTユーザーのみ)。

同じように、Impress Watchからニュースに関する質問に答えるチャットボットも作ってみた。こちらも作るのにかかった時間はほんの数分で、とても簡単だった。

次に、もう少し手の込んだチャットボットを作ってみよう。

最新のニュースを読み、シャーロック・ホームズっぽい語り口で、ホームズが好みそうな話題にだけ前向きにまとめて答えてくれるものだ。

この場合、日本語での語り口などについては何回か調整を加えて作っている。調整時間は30分ほど。だがほとんどの時間は、GPTの処理待ちの時間である。命名はこちらでやったが、アイコンはGPTが作ってくれている。

こちらも以下から使ってみていただきたい。

LLMを活用するには「方向付け」「カスタマイズ」が有用

この簡単さは確かにすごい。

チャットのスタイルを決める機能は以前からあった。また、ウェブを検索して情報を見つけたり、その内容についてある種の議論を進めたりすることだってできた。

だが、それをまとめて「チャットだけ」で設定していける簡単さは素晴らしい。途中で思ったような回答にならなくても、自分で簡単にその流れを調整できる。

現状、命令がチャットボットの設定に反映されるまでにかなり時間がかかることがあるが、結局これは処理速度の問題に過ぎないので、時間経過とともに解決されていくだろう。

ご存知のように、ChatGPTは文章による命令で生成AI(大規模言語モデル、LLM)に「なにかを生成させる」ツールだ。

質問をすれば回答してくれる、人間と同じように対話してくれるという点において、LLMは従来のAIよりも優れている。

多くの場合、文章を入力するために「質問」「検索」的な使われ方をするが、本来LLM「答えを聞く」のは向いていない。ある種のフォーマットに合わせて文章を再構築したり、文章を要約したりするのに向いている。翻訳に向くと言われるのは、「別の言語というフォーマットに書き換える」と考えるとわかりやすいだろう。

OpenAIのGPTシリーズは、LLMの中でも賢く、多言語に対応しており、なにより「ChatGPT」という優れたシンプルなユーザーインターフェースを持つことで一気に知名度を上げた。

だが、ChatGPTを毎日仕事で使っている、という人は意外と少ない。

結局のところ「なんでも書ける空欄」が用意され、「相手がなにを答えてくれるのかわからない」状況だと、意外となにをしていいかわからないものだ。

企業が「自社内の特定用途に生成AIを使う」という話はけっこう多い。自社内データベースの効率的な活用に向いているし、「こういう業務に使う」と一定のベクトルを与えることで、多くの人が生成AIの力を活用しやすくなることなどが理由だろう。

ただ、そうした「用途に合わせた生成AI」を作るには、これまで「開発」を経る必要があった。LLMやそのカスタマイズに関する知識を得て、ウェブアプリを作る能力も必要になった。

だが「GPTs」を使うと、それら前提知識は皆不要になる。単にチャットさえできればいいのだから。

LLMはプログラムをするのが得意だし、設定変更もフォーマットの一種だから得意だ。それを組み合わせたのがGPTsと言える。

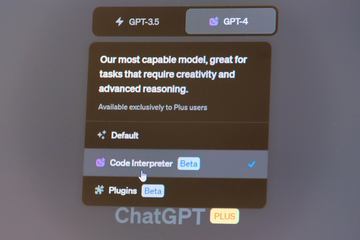

これは以前に発表された「Code Interpreter(現・Advanced Data Analysis。今回のアップデートでGPT-4を使ったChatGPTの基本機能に統合)」で感じた変化に近い。

Code Interpreter(Advanced Data Analysis)は、命令とデータを与えると、ChatGPTが内部で必要なPythonのコードを生成し、それに従ってデータ解析をしてくれるものだ。コードを知らなくてもデータ解析ができるのはすごいのだが、それ以上に、「コンピュータと会話しながらデータを解析していく」ダイナミズムが凄かった。

SF映画などで「コンピュータ、そのデータを解析。……その部分をもっとくわしく」などと、対話しながら目的に迫っていくシーンがある。それと同じことをChatGPTからできるという体験は、やってみないと凄さがわかりづらい。

GPTsも似ている。対話相手をAIと対話しながら作っていく体験は、いままでにない面白さがある。

先行する企業を「動くものを出す」で圧倒

GPTsの発想は新しいものではない。

様々な問題を解決するには、特定の知識に対して回答し、キャラクター性を持ったチャットボットが有用であろう、ということは多くの人々が指摘していたことだ。

10月にMetaは「Meta AI」を発表しているが、これも「特定の話題に答えるチャットボットを、キャラクター化する切り口で見せる」アプローチだ。

Metaは最初からセレブリティをキャラクター役として設定してわかりやすさを打ち出したが、1つの本質は、同時に提供される「AI Studio」にあった。誰でもコードを書くことなくLLMを使った専門性の高いチャットボットを作る、という意味ではGPTsと同じ考え方であり、発表自体は先行していたことになる。

しかし、Metaは英語でのテストを来年早々にスタートするという状況であり、「できたものを世の中に示す」という意味では、OpenAIに先行を許したことになる。

同様に、多くの企業が「ChatGPTのAPIを使ったチャットボットサービス」開発を手がけていた。しかしその多くはGPTsで再現可能になってしまうので、単純なものはみなGPTsに巻き取られてしまうだろう。

先行していると思われる企業もなぎ倒して進むダイナミズムが、今のOpenAIの凄みだろう。

「ローカル動作」「プライベート情報」で個人のコパイロイットに?

では今後どう進むのか?

自分で自分のためのチャットボットを作れるようになるなら、多くの人が「ちょっとだけ自分向けにカスタマイズしたチャットボット」を持つようになる可能性は高い。

そこでは単純な検索などではなく、自分が持つデータとの連携が必須になるだろう。過去のスケジュールやメール、ストレージ内のデータに再生した音楽など、使えるデータは色々ある。ただし、それらをちゃんと使うには、プライバシー面での配慮が必要になる。

そのためには「スマホやPCなどの中だけで、クラウドにデータをアップしないで処理するLLM」か、「すでにプライベートな情報をあずかっているサービス提供者が、個人のプライバシーを守ったまま動くよう作ったLLM」が必要になる。

前者については、アップルやクアルコムも進めている方法論であり、後者はGoogleが「Bard」の英語版に搭載してテストを進めている。

画像認識などのマルチモーダルな要素も入ってくれば、「自分が見ているものについて相談しながらなにかを進める」ことも可能になるだろう。

次に来る「コンパクトな自分のためのコパイロットを作る」流れがどうなるのか。考え始めるとなかなか色々な発想が駆け巡る。